- Após constatar o estado da arte da IA até 2024, agora é preciso aferir o que está por vir em 2025. Sobretudo após o Efeito DeepSeek-R1 e a mudança de rumos na Europa.

Damos, assim, continuidade à Parte 3 do ato 1, sobre os ciclos de maior ou menor “entusiasmo” com a IA, e a Parte 4, sobre quais os rumos da IA no mundo (onde a IA está mais “adiantada” em pesquisas, debates regulatórios e sobretudo influenciados por quem e quais conjunturas). Obs.: Se você não leu o ato 1, melhor fazê-lo o quanto antes para entender sua contextualização.

Entre fases de maior ou menor euforia e/ou frustração com os rumos dados à IA, penso que vivemos ainda um período de transição, marcado pela incertitude, mas de elevação do grau de amadurecimento do que está por vir. Logo, se fosse possível uma analogia quanto ao momento pelo qual estamos vivendo, me arrisco a dizer que se em 2024 estávamos na estação do outono, saindo do verão promissor para ir adentrar no tenebroso inverno de arrefecimento do hype e quebra de expectativas com a IA, já hoje, pelo ritmo dinâmico e incessante de inovação e interesse pela tecnologia, vejo que saltamos direto para a estação da primavera; ou seja, de retomada da esperança e novo alento para se começar a pensar em colher os frutos positivos que plantamos lá atrás através do fomento em pesquisas e financiamento.

Primavera esta que, em contrapartida, também alimenta a voracidade (ou seria necessidade estratégica?) de participar da disputa por sua liderança, dada a possibilidade de entrada de novos atores nessa corrida global pela IA (algo impensável anteriormente), uma vez que os demais players não querem ficar de fora, atrás de EUA e China, com leis restritivas demais, que entravem a competitividade e/ou impeçam a inovação.

Estaria, então, a União Europeia – UE arrependida de seu pioneirismo na regulamentação da IA? Caindo na real de que no ambiente digital regular somente não basta? De que é preciso sair da defensiva, ser mais proativa, ter infraestrutura e modelo próprio mas sem dispensar maior esforço colaborativo!? É o efeito DeepSeek agindo, assim como a AI Action Summit reverberando! Como eu havia avisado antes, lá atrás, sobre uma possível mudança de rumos na condução da IA na UE: saindo do idealismo para chegar à racionalidade.

Visto que, até 2024, o discurso que prevalecia é de que estaríamos desacelerando, saindo de um hype mais intenso para cair em um choque de realidade quanto aos caminhos possíveis com a IA. Visto que para a indústria já não havia o retorno esperado, não compensando os altos custos empregados, e os modelos – a seu ver – estariam estagnados, chegando-se a um limite do que seria seria possível atingir com os atuais LLMs (large language models).

Ao passo que ao raiar de 2025 se anuncia um novo ciclo, mais esperançoso, provando o contrário daqueles prognósticos sombrios, ao se vislumbrar “luz no túnel” no até então monopólio do Vale do Silício que, dentre outras tendências, concentrava poder e ditava o tom como se caminhavam as coisas (inclusive porque não havia – até então – concorrência estrangeira qualitativamente à altura, nem mesmo pela lado da China).

Foi nesse contexto mais otimista que, em janeiro de 2025, a startup chinesa DeepSeek lançou o aplicativo DeepSeek-R1 que, diferente ao ChatGPtT da OpenAI que liderava o mercado, chega de forma gratuita e de código aberto, porém atingindo “resultados equivalentes ou superiores aos dos modelos estadunidenses mais avançados“. Tanto que, em poucos dias, chega ao topo dos aplicativos mais baixados e bem avaliados para, uma semana depois, causar a queda de “cerca de US$ 1 trilhão no valor de mercado das grandes empresas americanas de tecnologia, refletindo a expectativa de um futuro da IA mais barato e acessível”.

Isto é, a China chega em contraponto à estratégia dos EUA que havia anunciado, no mesmo período, “o projeto Stargate – um plano de cinco anos, orçado em US$ 500 bilhões, para investir em infraestrutura de inteligência artificial”, lembra Dora Kaufman, professora da PUC- SP, referência no assunto.

E que o isso significa? Eis que, paradoxalmente, a aguardada mudança de rumos veio justamente pelo lado chinês, em reação e resposta direta à rivalidade sino-estadunidense. Pois se, em outrora, a disputa bilateral direcionava o ritmo como se desenvolviam as inovações com a IA, hoje permite à China demonstrar que é possível driblar as restrições impostas pelo concorrente (como tarifação e barreiras ao fornecimento de chips avancados) para, assim, propor soluções novas e criativas com (supostamente) menos capital financeiro e recursos computacionais.

Digo “supostamente” pela falta de maior detalhamento e transparência informacional até o momento, devido ao rígido controle na divulgação de dados e suas fontes. De oficial, o que sabemos vem do “material divulgado pela equipe que desenvolveu o DeepSeek“: de que “houve uma redução no número de etapas usadas na construção do chamado ‘modelo de linguagem’ [ou seja] foi possível construir o DeepSeek sem os equipamentos mais modernos”, graças ao método conhecido como “destilação” em modelos menores aos preexistentes:

A destilação de conhecimento é uma técnica de aprendizado de máquina que visa transferir os aprendizados de um grande modelo pré-treinado para um modelo menor, funcionando como uma forma de compactação e transferência de conhecimento (Kaufman, 2025).

Considerada uma prática comum na indústria, a destilação faz com que um modelo se destaque dos outros “não apenas pelo desempenho competitivo, mas pela sua eficiência em termos de custo e consumo de recursos“.

Por outro lado, “é importante colocar em perspectiva o sistema usado para construção do DeepSeek”, salienta Fabio Cozman, diretor do Centro de Inteligência Artificial da USP. Pois apesar da considerável redução de custos (de 40 a 60%), esta não se reflete em todas as áreas: “pelo que sabemos, foram cerca de 2000 placas que custam pelo menos cerca de 30 mil dólares cada. Ou seja, o investimento feito em torno do DeepSeek não foi pequeno”.

Efeito DeepSeek: startup chinesa fura a bolha do ChatGPT e retoma o hype da IA

O grande feito da DeepSeek foi, então, desfazer a premissa de que a liderança em IA era uma questão puramente de capital. E que, portanto, desenvolvedores menores ficariam à margem dessa disputa. Tanto o é que os EUA haviam anunciado um investimento bilionário no objetivo de alcançá-la, visando – ainda que hipotética – a singularidade. Já que o modelo estadunidense seguia o entendimento que “o poder da inteligência artificial seria diretamente relacionado ao tamanho da infraestrutura em que ela opera.” Logo, “quanto mais chips, servidores, datacenters, dados e energia, mais poderosa a IA.” Como demonstra o quadro abaixo:

Só que, em termos de inovação, a China apostou em nova abordagem e funcionamento de seu modelo por meio da otimização em duas fases: a fase de treinamento, mais eficiente, que reduz os recursos computacionais necessários para alcançar a mesma qualidade, e a fase de uso, com várias versões menores, mais fáceis de executar em dispositivos menos potentes (Kaufman, 2025).

E foi assim, com esforço criativo e menos recursos à disposição, que a startup chinesa conseguiu provar o contrário, mostrando um novo modelo que, enfim, consegue furar a bolha do ChatGPT e retomar o hype em torno da Inteligência Artificial! Além de pavimentar caminhos possíveis – agora mais próximos, porém ainda inalcançáveis – para a singularidade ou uma inteligência artificial geral (que, convenhamos, é o ideal a ser alcançado por todos, inclusive a União Europeia que acaba de entrar na mesma batalha de EUA e China, só que agora focada menos nos riscos da IA, tornando-se mais competitiva no setor).

Potências médias poderão agora competir de igual para igual com modelos menores?

O ‘Efeito DeepSeek‘ sinaliza especialmente para as potências médias, como o Brasil, que é possível competir mesmo baixando custos e dispondo de menores recursos. Uma vez que o rival asiático não só furou a bolha hemisférica, como também finalmente chegou com produtos à altura (DeepSeek e Qwen) ou até mesmo superiores aos das concorrentes norte-americanas, como o ChatGPT da OpenAI e I AM AI da Nvidia. Afinal, segundo Cozman:

a redução possibilitou que a empresa cortasse custos drasticamente sem comprometer a qualidade da plataforma. Supõe-se que o desenvolvimento do DeepSeek custou por volta de US$ 6 milhões, enquanto mais de US$ 100 milhões foram investidos no GPT-4, modelo da OpenAI conforme sugeriu o CEO Sam Altman em evento realizado em 2023.

Tal vantagem competitiva se deu pelo fato de os produtos de IA chineses serem mais baratos, eficientes e principalmente mais sustentáveis do ponto de vista de redução do enorme volume de água e energia consumidos por data centers e fazer rodar esses sistemas, uma vez que necessitam de infraestruturas menores. O que é uma mensagem de alento para o planeta no instante em que os EUA vão na contramão dessa “pegada ambiental” que pretende discutir e promover uma IA de verdadeiro interesse público global.

Principalmente quando nesse hiato, mais voltado pra si, o segundo governo Donald Trump abre mão de compromissos internacionais, não adere ao AI Action Summit (Cúpula de Paris sobre uma IA ética, aberta, inclusiva, transparente e confiável) e “revoga a Ordem Executiva de 2023, assinada por Joe Biden, que buscava reduzir os riscos da IA“. Essa reviravolta, ao que parece um retrocesso, desmantela uma medida que constituía um passo importante para um futuro mais ético e responsável da IA. Pois, mesmo sem força legal, “exigia que desenvolvedores de IA compartilhassem resultados de testes de segurança com autoridades governamentais antes de lançarem os produtos no mercado, além de orientar agências a definir padrões para tais”.

Em outras palavras, ao que tudo indica, os EUA de hoje preferem não ficar sob as amarras de nenhum acordo ou agenda global que limite seu potencial inovador, imponha regras excessivas ao desenvolvimento da sua IA e/ou pactue com idealismos e regimes autoritários (como o da China, signatária do AI Action Summit e co-organizadora do evento). Nem que sua ausência no pacto global implique no caso extremo de inexistir nenhuma regulamentação em Inteligência Artificial para os cidadãos norte-americanos. Ou, no caso da não adesão do Reino Unido, optar por não ficar nem de um lado (EUA) nem do outro (União Europeia), por ir de encontro a seus interesses nacionais.

Há novos protagonistas em Inteligência Artificial?

A atual postura dos EUA em não ser conivente com nenhum acordo multilateral sobre o desenvolvimento aberto, colaborativo, mais durável e sustentável em IA para as próximas gerações tem a ver com a ideia de que, hoje “amarrados por normas e tratados internacionais”, um dia possam ser superados por concorrentes não signatários. Pois se antes o adversário era a China, agora há a concorrência também com a Europa, já que esta entra de vez na batalha da IA através de investimento total de cerca de € 200 bilhões. Considerado o projeto mais ambicioso desde a criação do euro, o InvestAI planeja fazer da UE uma terceira força em IA.

AI Action Summit 2025

Um Pacto global sobre a IA hoje é possível graças a uma visão mais amadurecida e positiva da IA, focada no seu potencial futuro e menos no lado ruim dos perigos existenciais para a humanidade. Pois “ao contrário dos dois primeiros AI Action Summit, a edição de Paris não está focando nos riscos da IA“, e sim nas “capacidades da tecnologia de acelerar o progresso”. O que demonstra uma mudança de visão da indústria de IA, mais pragmática, ao concentrar seus esforços no lado bom da tecnologia:

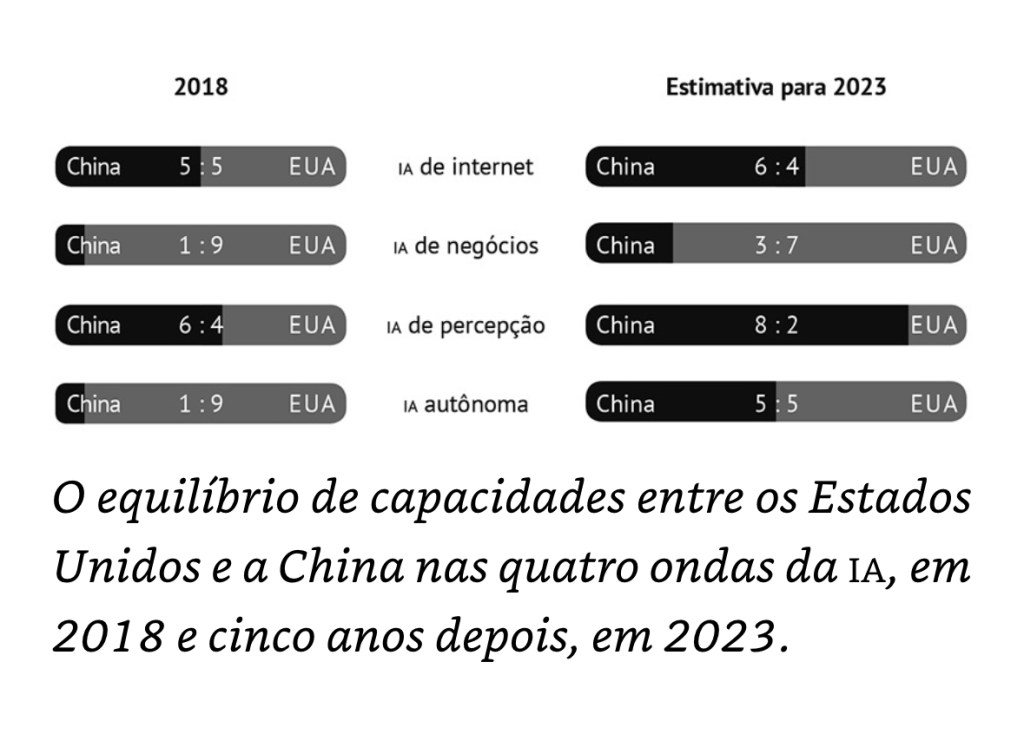

Nesse sentido de tornar o desenvolvimento da IA menos centrado e mais colaborativo, a inovação chinesa vinda da DeepSeek é bem recebida porque propicia modelos mais acessíveis (open source) aos pequenos desenvolvedores, sejam brasileiros ou europeus, quebrando o monopólio e a concentração de mercado da IA por Big Techs (grandes empresas de tecnologia), na sua maioria rivais estadunidenses. Mesmo porque não era uma questão de se, e sim quando a China faria frente aos EUA, alcançando-os em algumas das aplicações da IA (à luz dos prognósticos de Kai-Fu Lee em AI Superpowers: China, Silicon Valley, and the New World Order, um livro de 2018, mas que já fazia essas projeções, particularmente sobre a quarta onda da IA autônoma). Vide o quadro abaixo:

Os argumentos do autor vêm no sentido de a China passar à frente dos EUA por pensar estrategicamente a longo prazo, a exemplo do “Plano de Desenvolvimento para uma Nova Geração de Inteligência Artificial” já em 2017. E ao cumprir metas estabelecidas, como as de a) se tornar uma superpotência em IA; b) ser a maior das economias de IA até 2020; c) alcançar novos avanços até 2025; d) tornar-se líder mundial em IA até 2030.

Assim sendo, a vantagem competitiva chinesa viria (também) a partir da continuidade de políticas de Estado, e não de governos que invariavelmente descontinuam as políticas de seu antecessor (que, aliás, foi o que de fato aconteceu, em 2025, entre as gestões Biden e Trump). Kaufman faz raciocínio semelhante ao apontar que para se ter uma IA competitiva “o que se requer, acima de tudo, são estratégias de Estado, e não apenas de governo”.

Tratam-se, ademais, de iniciativas de macro e micro economia combinadas. Ou seja, a partir de políticas públicas de mobilização nacional aliadas a uma cultura de startups de proteção ao copyright (marcas registradas), direitos autorais e patentes, porém de forma mais flexível que a de seus adversários, devido a menos restrições à propriedade intelectual. Dado ao fato de a China acreditar que a inovação pode se dar tanto pela via disruptiva quanto incremental, aprimorando o que já existe (contrapondo-se à tradicional visão estadunidense de que isto constitui cópia e trapaça, através de práticas não autorizadas de replicação).

Nota [para melhor entendimento da magnitude dessa briga de titãs, ver resumo do mesmo autor em China Como Líder Global em Inteligência Artificial: Repercussões Éticas, Sócio-Técnicas e Geo(Políticas) para o Mundo, ou em seu artigo completo, pp 333-344, recém publicado].

Então, zero surpresa quanto ao que vem sendo considerada uma possível quebra de paradigma por parte da China (digo “possível” pois trata-se de uma provável ruptura, mas a se confirmar a posteriori, dado o ritmo dinâmico como estão se dando as inovações e saltos tecnológicos – cada vez mais breves – com as Inteligências Artificiais).

Em contrapartida, não significa que outras potências conseguirão replicar o mesmo feito da China, justamente pelas características que lhe são peculiares, como a de pensar estrategicamente a longo prazo, salienta Kaufman:

os resultados bem-sucedidos da DeepSeek refletem tanto a cultura chinesa — caracterizada pela colaboração e pela busca por inovação a partir do que já existe — quanto a estratégia estatal de inteligência artificial. Em 2016, o governo da China reconheceu a IA como uma tecnologia chave para o crescimento econômico do país e, em 2017, lançou um plano para se tornar líder global em IA até 2030, com ênfase na criação de um ecossistema tecnológico independente e autossustentável.

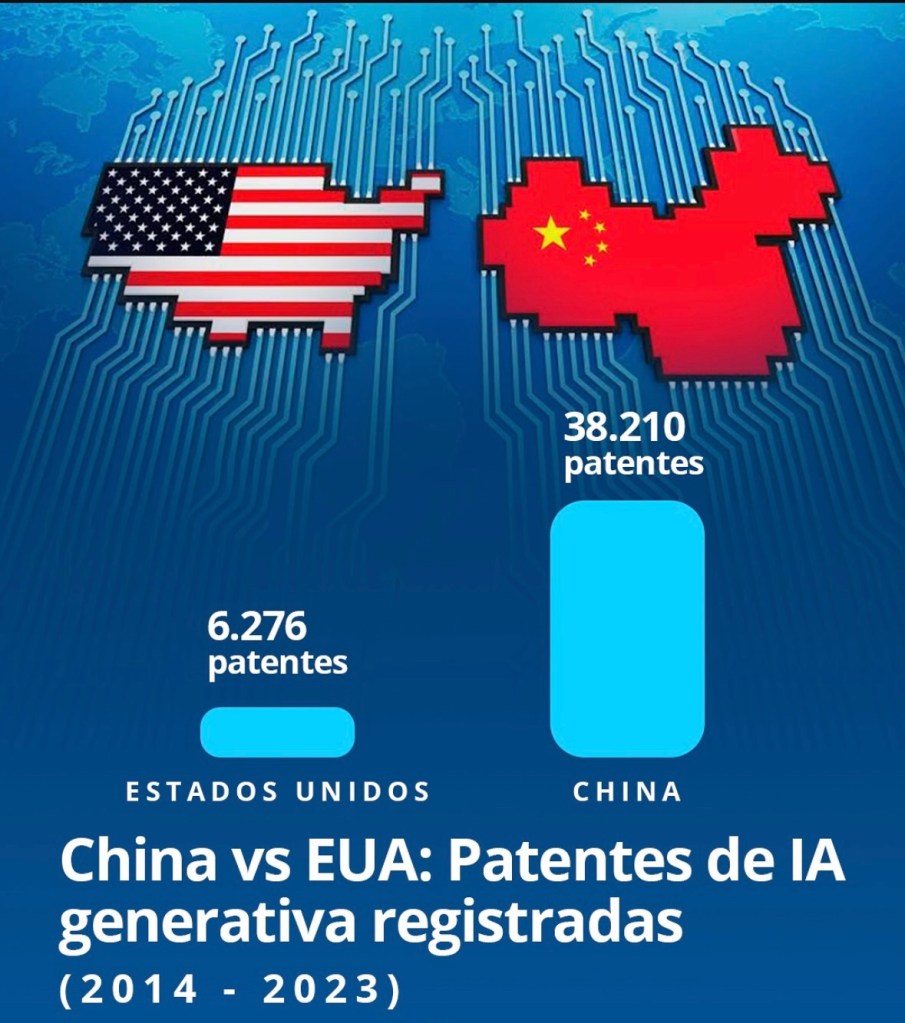

Para tanto, “entre 2014 e 2023, a China registrou mais de 38 mil patentes relacionadas à IA, enquanto os EUA registraram 6.276 patentes no mesmo período“. Só para ter uma ideia do tamanho dessa diferença, “desde 2017, a China publica anualmente mais patentes em IA do que os demais países juntos“. Portanto, não se sustenta mais a retórica de cópia e pirataria que envolve questões não meramente concorrenciais, mas também éticas, de desacreditamento do potencial chinês (vide quadro ilustrativo):

O outro lado da moeda: limitações ao DeepSeek-R1

Podemos afirmar, desde já, que a DeepSeek virou o jogo? Ou, mais ainda, que houve fim do monopólio da OpenAI ou mesmo quebra de paradigma em favor da China (isto é, a superação de uma potência hegemônica por outra emergente)?. Muita cautela nessa hora, visto que o modelo chinês também encontra suas incoerências e limitações.

Embora alardeado como um modelo open source (de código aberto), a startup chinesa adota uma postura semelhante a de outros modelos que se dizem “abertos”, tais como o Llama, da Meta. Ou seja, apesar da narrativa de IA aberta e inclusiva (para os céticos, em tom marqueteiro), a China usa da mesma estratégia de seus concorrentes. Isto é, ao se envolver em um impasse de natureza concorrencial, evita expor os segredos industrial e comercial chineses ou mesmo comprometer sua propriedade intelectual (ver mais do mesmo autor em China, Big Techs e os Fator Concorrencial em Jogo).

Já que, na prática, a DeepSeek também “não divulgaria os conjuntos de dados nem o código de treinamento para criar seus modelos.” Aliás, uma postura protecionista de sigilo que remete aos primórdios da OpenAI que começa aberta e depois se fecha. Ensejando questionamentos se esta algum dia foi mesmo aberta ou apenas no nome.

Outra questão que não chega a desacreditar ou abalar sua popularização no Ocidente, mas suscita especulações quanto ao modelo de IA chinês ser menos seguro e confiável que os demais está relacionada à opacidade, dadas as restrições do governo que impedem que seus modelos de IA generativa produzam conteúdos sensíveis à China e/ou contrários aos “valores socialistas essenciais”, a exemplo de “tópicos historicamente censurados, como a repressão na Praça Tiananmen e a questão de Taiwan“. Assim, ao invés de prover uma resposta precisa a respeito, se esquiva com ‘sorry, that’s beyond my current scope’!

O professor Gustavo Macedo, no entanto, ao lembrar o viés político de uma tecnologia que, por essência, não é neutra, questiona se tal medida faz o modelo de IA chinês ser menos confiável que o dos seus concorrentes. Pois, tal “denúncia teria um objetivo comercial: diminuir o valor de uma IA que ameaça os grandes players norte-americanos“. Segundo ele:

O que muitos esquecem é que IAs ocidentais também tiveram respostas enviesadas no passado. Elas foram corrigidas e, com o tempo, passaram a ser vistas como confiáveis (…) Isso porque ela é resultado do trabalho humano – e todo trabalho humano é político. Da construção dos dados à organização dos bancos de dados, do treinamento dos algoritmos à comercialização dos serviços, a política perpassa todas essas etapas.

E finaliza: “o problema não é reconhecer que a IA é política. O problema é não reconhecer isso – e, assim, fechar os olhos para a necessidade de lidar com essa realidade. Profissionais e empresas que ignoram o caráter político da IA correm o risco de cair em armadilhas nos próximos anos“.

Afinal, havia como deter o ChatGPT (?)

Lucia Santaella, em seu livro de 2023, já indagava se havia como deter a invasão do ChatGPT. Visto que o boom advindo com o ChatGPT foi o primeiro grande divisor de águas nas discussões que colocaram à prova as reais capacidades dos atuais modelos de IA.

No entanto, a pergunta que cabe agora, em 2025, é: se o lugar de destaque da IA generativa se consolida primeiro com o ChatGPT e depois com o DeepSeek-R1, os supostos entusiasmos ou desapontamentos com a IA eram na realidade para qual grupo de interesses: para a indústria ou o usuário? E relativos a o que exatamente? Passados dois anos depois, já possível esclarecer…

- A virada de chave dos LLMs da IA Generativa (IAG)

Sabemos que nos dois últimos anos os holofotes se voltaram rapidamente da Inteligência Artificial preditiva para a Inteligência Artificial generativa tanto em questão de velocidade quanto em volume de escala advinda da grande adesão pública e democratização de acesso ao ChatGPT, ferramenta da OpenAI que foi lançada ao final de novembro de 2022.

Pois enquanto a IA preditiva quase sempre foi alvo de resistências, por se tratar de um mercado mais nichado e centralizado em poucas empresas particulares e do governo, a usabilidade da IA generativa, por sua vez, a deslanchou! E isso provavelmente se deve ao fato de procurar mimetizar a linguagem, uma das características mais inerentes a dos humanos. Sobretudo, advinda de seu diferencial, não só o meio de comunicar entre si, mas também de conseguir “padronizá-lo”.

Do inglês Chat Generative Pre-trained Transformer, o nome ChatGPT resulta da combinação das funcionalidades de um “chatbot” com a de um “GPT” – Generative Pre-trained Transformer ou Transformador Pré-treinado Generativo, uma espécie de grande modelo de linguagem ou LLM – Large Language Model. Com base nesse modelo, usa os prompts (comandos do usuário) como contexto para conseguir lhe gerar respostas (daí a nomenclatura IA generativa – GenAI), prevendo então as palavras que seriam mais pertinentes e adequadas às perguntas formuladas. Como as respostas resultam desse tipo de treinamento (interação humano-máquina), aquele permite que o usuário vá refinando suas perguntas até que consiga direcionar o sistema conversacional para a duração, o formato, estilo, o nível de detalhamento e a linguagem desejados.

Daí em diante não foi por acaso o boom de sua popularização, assim como dos incrementos crescentes na experiência do usuário (UX) não só com o ChatGPT, mas com outros sistemas de IA concorrentes, tais como “Gemini, Ernie Bot, LLaMA, Claude e Grok“. E, por conseguinte, a facilitação de adesão a tais sistemas e o modo pela qual foram ficando mais acessíveis.

Não à toa, portanto, que o ChatGPT se tornou o produto mais popular e rapidamente difundido na história da internet, “conquistando 100 milhões de usuários ativos em apenas dois meses“. E os saltos temporais são impressionantes:

“Enquanto o ChatGPT levou cerca de 60 dias para chegar aos 100 milhões de usuários ativos, o TikTok levou nove meses para atingir o mesmo número. Já o Instagram precisou de ainda mais tempo: foram dois anos e meio para alcançar os nove dígitos”.

Logo, os avanços com o DeepSeek-R1 não fugiram à tendência de dinamização incessante das IAs: o que muda na superação de um modelo para o outro não está, entretanto, adstrita à duração pra mais ou pra menos dos seus lapsos temporais, mas também quanto à adoção de diferentes abordagem, finalidade e funcionamento. E nada se encaixa melhor nesse contexto que o “efeito Dunning-Kruger: quanto menos uma pessoa sabe, mais ela acha que sabe“. Pois, assim, subestimam-se as capacidades das outras diante, principalmente, das suas adversidades nesse campo do conhecimento em constante transformação.

Para conseguir superar o modelo rival mesmo em sua sua versão paga (ChatGPT 4), a um custo mais baixo, de melhor performance e, ainda assim, transformar a IA generativa tal qual a conhecíamos, o R1 teve como diferencial os chamados MoEs (Misture of Experts), a arquitetura por trás que fundamenta o modelo chinês. Por intermédio dessa abordagem e funcionamento diferenciados, há quem diga que o DeepSeek-R1:

simboliza uma mudança de paradigma no desenvolvimento de LLMs (grifos nossos), mostrando que excelência não está necessariamente atrelada a recursos financeiros exorbitantes, mas sim a inovações arquitetônicas. Sua adoção do MoE desafia a supremacia das arquiteturas transformer tradicionais, demonstrando que é possível equilibrar profundidade, especialização e eficiência computacional (Santaella et al, 2025).

Portanto, quanto aos diferenciais técnicos, os MoEs destacam-se:

a) primeiro, no incremento de modelos anteriores, a fim de maximizar eficiência e precisão. Tanto da mesma “família”, como o DeepSeek-V2, quanto rivais, como o da Nvidia, famosa fabricante de chips avançados de IA que sofreu um prejuízo de 17% em suas ações, “correspondendo a uma redução de US$ 589 bilhões em sua capitalização, a maior já registrada por uma única empresa em um único dia no mercado acionário americano”. Em termos práticos, isso significou “reduzir os limites impostos por arquiteturas tradicionais, abrindo novas possibilidades em escala, especialização e acessibilidade”;

b) no gating function, “capacidade de dividir o trabalho entre diferentes ‘especialistas’ — partes do modelo treinadas para lidar com tipos específicos de dados ou tarefas”, implicando em uma maior especialização no seu modus operandi. Logo,

ao invés de utilizar um único modelo monolítico para processar todas as entradas, o MoE distribui a carga computacional, ativando apenas os especialistas mais relevantes para a tarefa em questão. Essa ativação seletiva não apenas melhora a eficiência, mas também possibilita a especialização sem aumentar o custo computacional de maneira linear (Santaella et al, 2025);

c) na otimização de recursos ao longo do treinamento. Assim, ao invés de “treinar um modelo menor por mais etapas, os MoEs permitem que modelos maiores sejam treinados em menos iterações (iteration), otimizando o orçamento computacional“;

d) na transparência de suas operações. Assim, quando o usuário solicita a geração de um código em Python, “o modelo não apenas entrega o resultado, mas também fornece uma explicação detalhada de como está ‘pensando’ (thinking) ao processar o comando”. Sendo capaz, ao contrário de muitos, de contextualizar e justificar suas respostas;

e) no processamento dos prompts (comandos): a arquitetura diferenciada dos MoEs permite avaliar “a relevância de cada palavra dentro de uma frase, atribuindo pesos matemáticos a tokens e identificando relações semânticas em um espaço multidimensional”. Assim, quando o usuário escolhe determinado prompt (comando), “o modelo analisa a ordem das palavras, suas conexões e o peso semântico relativo para gerar a melhor resposta possível“. A partir desse avanço tecnológico, reacende a importância dos prompts na geração de textos, vídeos e imagens sintéticas já aludidas por este autor, principalmente entre os menos familiarizados com essa interação humano-máquina;

f) na sua estratégia de treinamento, ao adotar uma abordagem mais seletiva que o maxima em eficiência e reduz drasticamente a redundância, no que resulta em menos consumo energético e barateamento dos custos em treinamento;

g) por fim, e não menos importante, na priorização da “eficiência energética e acessibilidade, utilizando GPUs de forma inteligente e escalável“.

Em síntese, a fim de se chegar a resultados realmente diferenciados, o sucesso de novos modelos de IA como o da chinesa DeepSeek (por ora):

reforça a importância de integrar inovações técnicas com uma compreensão profunda da semântica e do potencial que reside em cada prompt, reafirmando que, no campo da IA, o verdadeiro diferencial está no equilíbrio entre eficiência e especialização (…) integrada à capacidade de personalização pelos usuários (…) e uso inteligente dos recursos computacionais (Santaella et al, 2025).

Considerações finais

Diante da criatividade, especialização e profundidade dos novos modelos de IA há como driblar as barreiras impostas, tornando-se inócuos tanto os esforços para banir totalmente ou ao menos conter o avanço global da DeepSeek tal qual como ocorreu com outras plataformas chinesas no Ocidente, a exemplo do caso recente do TikTok (do mesmo autor ver China como Líder Global em Recomendações Algorítmicas por Inteligência Artificial: repercussões do TikTok para o mundo), quanto as crescentes restrições comerciais aos semicondutores e chips avançados de IA para a China.

Alinho-me, então, ao entendimento de que, ao disponibilizar gratuitamente essa arquitetura open source, já amplamente difundida e adotada pela comunidade global de desenvolvedores, tornam-se inviáveis as atuais medidas restritivas ou que, ao menos, tentem centralizar seu uso junto ao monopólio das Big Techs estadunidenses.

Afinal de contas, a característica que consolida a DeepSeek no mercado é justamente a capacidade de permitir que seu modelo de Inteligência Artificial “seja adaptado, aprimorado e integrado a diversas aplicações sem depender de uma única entidade ou jurisdição“, tornando-o de verdadeiro interesse público global.

E embora se ventile a ilusão trazida por modelos de linguagem aberto (que de aberto não haveria nada, já que através de técnicas questionáveis como cópias, atalhos e imitações nada se cria e muito se apropria, nem sempre da forma devida, de dados e código-fonte de modelos já lançados; violando – assim – direitos autorais, à propriedade intelectual e privacidade para desenvolver sua própria indústria), no mais, o que nos resta daqui pra frente é aguardar a inevitável superação de um modelo de IA por um mais potente que o outro em alguns dos testes sobre suas reais capacidades.

Se hoje é a vez do DeepSeek-R1; amanhã será a do Deep Research da OpenAI; depois a do Grok 3 da xAI, empresa de Elon Musk cuja IA já foi auto-intitulada, por ora, como “a mais inteligente do mundo“, apesar do altíssimo custo computacional. E assim por diante…