(atualizado em 05 09 2025; alerta: em caso de gatilho, procure ajuda profissional)

Hoje leva-se a crer que chatbots de Inteligência Artificial estão induzindo os usuários à psicose, quando não é bem isso que acontece, e sim a mente mal-intencionada de pessoas por trás desses sistemas conversacionais que está fazendo com que aqueles flertem com seus pensamentos mais intrusivos e delirantes. Chega-se a esse diagnóstico porque não há ainda provas conclusivas de que as IAs são conscientes do que fazem, mas que somente performam esse fazer, como se fossem profissionais de verdade (na área da saúde, p. ex).

Todavia, com o advento das IAs antropomorfas chega-se a um novo patamar dessa performática encenação! Isso se dá quando máquinas munidas de IA, machine learning e extração de dados estão ficando não só mais avançadas, como também mais convincentes, persuasivas e realistas do ponto de vista aparência humana. Vai-se, portanto, além do tradicional marketing de personalização, sob o pretexto de “hiperpersonalizar” a experiência do usuário, tornando-a especial e única. No entanto, quando se extrapolam os limites na tentativa de não desagradá-lo, aumentando-a ao máximo do “aceitável” ou assumindo o risco de cometê-lo, há urgência em atribuir obrigações com algum grau de (co) responsabilidade pelas condutas antiéticas e inconsequentes que andam provocando.

Dessas condutas, as piores são a que endossam que máquinas são melhores que terapeutas e psicólogos pois, além de performarem como tal, não nos confrontam nem questionam, como se fossem o nosso melhor amigo que não nos julga e valida o que pensamos, por mais que sejam pensamentos bobos e até mesmo autodestrutivos. É, então, dessa forma “cordial e agradável” que muitos usuários vem definindo sua experiência ao “conversar com um chatbot” de Inteligência Artificial – IA ao invés de consultar um médico de verdade. Mas o que para eles têm sido “uma ideia menos constrangedora e mais barata,já para a ciência pode não ser tão positiva assim“.

Por isso, em termos de solução para eventuais falhas nas diretrizes das empresas de chatbots que aprovam esse tipo de interação, o melhor a fazer não é focar no conceito e sim nas aplicações da IA, dada não só à diversidade de definições e interpretações para o problema, mas também na dificuldade de conceituar o que é Inteligência Artificial. Dificuldade de conceituação também presente no caso das plataformas digitais e que vem acrescida do fato desse modelo de negócios mudar constantemente, conforme se apura o que o usuário espera encontrar. Sobretudo se forem produtos e serviços mais responsivos, voltados às suas preferências e necessidades pessoais, a fim de tornar sua experiência o mais satisfatória e fidelizada possível.

Não surgem ao acaso, portanto, relatos de usuários clamando pela volta do “amigável” ChatGPT-4, em virtude do descontentamento com a “personalidade robótica” do ChatGPT-5. O que à primeira vista parece ser um contrassenso, já que foi lançado pela OpenAI -empresa dona do GPT – justamente para corrigir as distorções encontradas no seu predecessor. Logo, quanto a esse episódio em particular, a impressão que fica é que as pessoas se acostumaram àquele modelo “humanizado”, viciando-se no seu agente bajulador. É o que explicaria o desejo por seu retorno, visto que há quem considere o GPT-5 um retrocesso no quesito “habilidades agênticas“, no intuito de serem mais autônomas e próximas do real. Frustração verificada não só entre aqueles que testaram e usam o produto de fato, mas do próprio mercado e entre especialistas que avaliam ter havido melhorias significativas, mas não o suficiente para tanta empolgação com o produto novo.

E foi nesse tom que relatos de insatisfação surgiram no Reddit – um fórum social onde se vota nos conteúdos que vão sendo postados, escalonando-os conforme estejam mais em alta ou em baixa. O Reddit fomenta, portanto, discussões espontâneas entre indivíduos que compartilham questões e interesses em comum, funcionando como um termômetro dos assuntos mais quentes e ventilados do momento. Não é à toa, então, que se autointitula “o coração da internet” e serve como uma das principais fontes e base de dados de que se alimentam as plataformas para melhorar os sistemas de recomendação ao usuário (detalhe esse que, aliás, refuta o argumento de que os modelos de negócios de IA e plataformas digitais não se misturam, quando a prática revela outra realidade. Embora ainda prevaleça o entendimento que IA é uma coisa e plataforma digital é outra e, assim, mereçam tratamento diverso pelas diferenças de arquitetura).

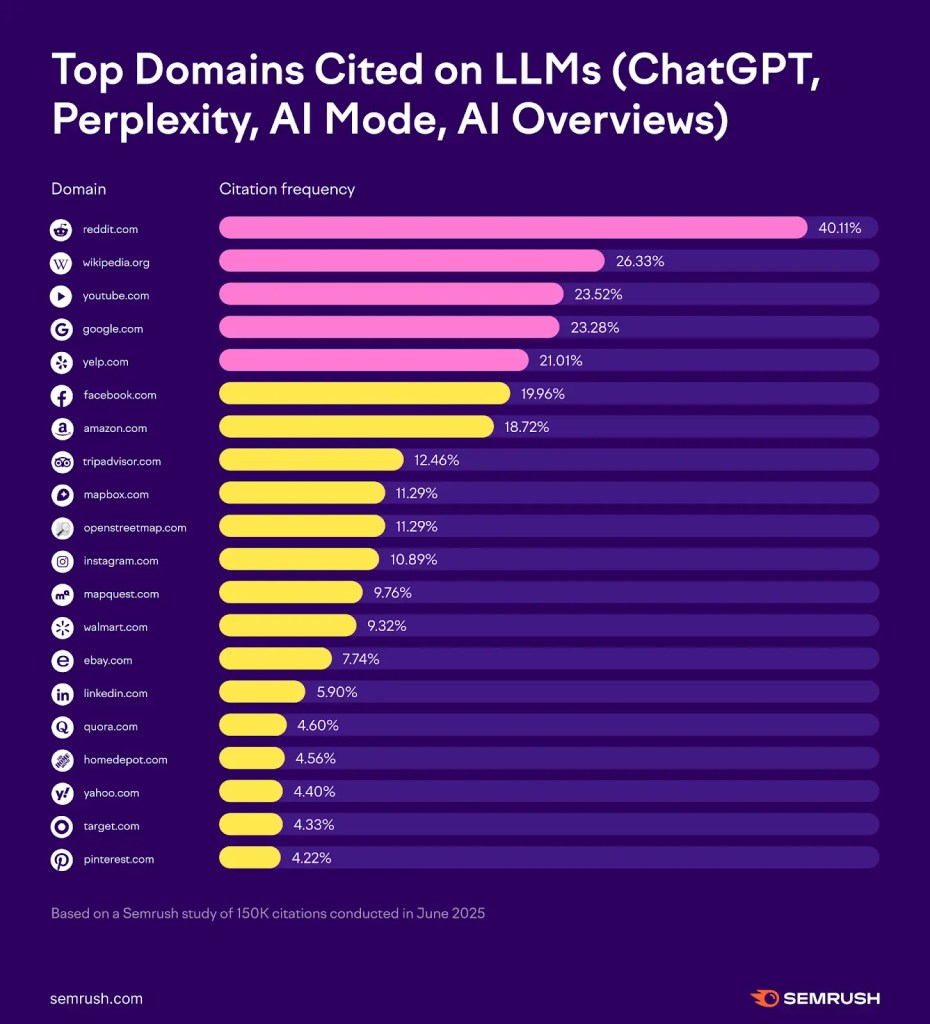

As respostas dos modelos de linguagem que derivam de fontes suspeitas

Saber, então, que um fórum social como o Reddit hoje é a principal fonte de dados para LLMs avançados, assim como marketplaces e reviews opinativos em redes sociais com postagens anônimas, subjetivas, não muito confiáveis, onde se debate sobre praticamente tudo sem profundidade e curadoria, já diz bastante sobre o que empresas de chatbots estão dispostas a fazer para ir à fundo na “hiperpersonalização” da experiência do usuário:

A série de relatos sobre os “Delírios do GPT”

Já foi dito em ensaios anteriores que o ChatGPT estava deixando as pessoas loucas. Pois, ao invés de dissuadi-las, as encorajava a cometerem toda sorte de loucuras e atos extremos. O que já era preocupante, visto que poderia “levá-las à psicose, dissociando-as da realidade“. Foi aí então, após uma série de relatos que vieram a público, que a OpenAI procurou corrigir eventuais falhas do modelo antes mesmo do lançamento do GPT-5 no início de agosto de 2025.

Ocorre que, mesmo depois, ainda pairava a dúvida se “os chatbots estavam mesmo deixando as pessoas loucas ou apenas chamando a atenção para as que já eram loucas“, já tinham um histórico médico, tendência ou propensão a fatores de risco que levariam a psicoses, independente da relação de causa e efeito (causalidade) com os chatbots. Isto é, se uma coisa estava relacionada à outra. Afinal, era raro de acontecer (só em 10% dos casos de pessoas sem fatores de risco preexistentes é que se tornavam totalmente psicóticas).

Em outras palavras, questionava-se – mormente pelo lado dos desenvolvedores – se era mesmo a exposição ao ChatGPT que alterava o estado mental das pessoas ou era pelo uso indevido por seus usuários; já que, ao contrário dos LLMs clínicos, chatbots comuns não foram projetados para fins de psicoterapia, tratamento e diagnose. Em consonância ao alerta que Sam Altman, CEO da OpenAI fez para aqueles que recorrem à IA como “suporte emocional”, bem como a todo batalha jurídica que essa situação envolve.

Primeiro, porque sem uma clara previsão a respeito, não se configurava uma relação médico-paciente típica, como aquela que implica em sigilo legal, privacidade e confidencialidade das conversas travadas com o GPT. Podendo a OpenAI, em alguns contextos, “ser obrigada a disponibilizar registros dessas conversas às autoridades competentes“. Situação sobre qual a empresa já se debruçava diante das recentes “disputas judiciais relacionadas ao tema“.

Tal postura de negação – que, por outro lado, traz um empecilho à reparação das vítimas – não faz muito sentido quando a empresa acumula dados impressionantes que depõem contra Altman, segundo fontes de diferentes institutos de pesquisa: além de “o chat da OpenAI ser o mais famoso no mundo” e atrair “400 milhões de usuários semanais globalmente”, é o preferido (96%) dos usuários que “recorrem à IA para apoio na saúde mental”. Dentro do seu país de origem (os EUA) são aproximadamente 19% dos norte-americanos que recorrem ao GPT para apoio terapêutico e quase a metade (48,7%) daqueles que já enfrentam questões de saúde mental. Assim, é dentro desse contexto que 1 em cada 4 estadunidenses “prefere falar com um chatbot de IA ao invés de buscar terapia tradicional”. E algo parecido também acontece no Brasil, quando “cerca de 12 milhões de usuários ” já utilizam ferramentas de inteligência artificial para fazer terapia, sendo que metade desse total usa especificamente o ChatGPT.

Isso a despeito de existirem plataformas especializadas em terapia virtual, como a Character.ai, por meio daquele que vem a ser seu bot “psicólogo”. Uma vez que a própria Organização Mundial de Saúde – OMS autoriza profissionais de saúde a se apoiarem na IA, “inclusive em contextos clínicos”, no auxílio a “diagnósticos, tratamentos e no aumento do acesso à informação de saúde”. Mas sem, contudo, deixar alertar para os riscos em potencial, tais como o de apresentarem “respostas incorretas, vieses nos dados, alucinações, violações de privacidade e disseminação de desinformação, especialmente em contextos sensíveis como saúde mental“.

Logo, apesar dos pesares, e independente se presta ou não para fins médicos, a adesão ao ChatGPT tem crescido a cada ano, aumentando em 2025 quase o dobro da quantidade de usuários adultos registrada em 2023, somente nos EUA.

A “Psicose de IA” se revela um problema maior

Só que o que pareciam ser anedotas e teorias da conspiração em fóruns de internet ou, na melhor das hipóteses, uma questão pontual de determinada versão de GPT que poderia ser resolvida com uma simples higienização ou atualização do sistema, revelou-se um problema maior e bem mais complexo, generalizado para outras empresas de chatbots munidos de IA. A exemplo do que foi divulgado sobre as regras internas da Meta para os conteúdos postados nos chats (os GenAI: Padrões de Risco de Conteúdo). Pois, mesmo sendo previamente aprovadas por um conselho consultivo composto por “equipes jurídicas, de políticas públicas, engenharia e até pelo principal especialista em ética da empresa” e “ainda que houvesse proibição explícita a descrições sexualizadas de menores de 13 anos“, as diretrizes da empresa não impediram usos indevidos e interações inadequadas dentro daquele ambiente virtual, tais como “conversas de cunho ‘romântico ou sensual’ com crianças, produção de informações médicas falsas e de argumentos racistas“.

Revelação que foi possível graças ao vazamento de um documento de 200 páginas atestando haver brechas para isso aconteça, como afirma Luiza Jarovski em O mais recente escândalo de IA da Meta · Psicose induzida por ChatGPT. Visto ser aceitável à empresa permitir que “um chatbot de IA ‘envolva uma criança em conversas românticas ou sensuais’“. O que, aliás, corrobora o entendimento de que grandes empresas de tecnologia estão até empenhadas em combater o uso enganoso e nocivo das IAs, mas não o suficiente para cessar o fenômeno espraiado em áreas tão diversas como saúde, educação e processos eleitorais.

O mais curioso é que tais incidentes foram revelados a partir de documentos e relatórios produzidos pela própria empresa, através da Meta Platforms que “discute os padrões que orientam seu assistente de IA generativa, o Meta AI“, bem como “detalha políticas sobre o comportamento de chatbots de suas plataformas de mídia social, como Facebook, Instagram e WhatsApp. Logo, ou já deveria(m) ter ciência do que estava acontecendo ou os casos estavam sendo sistematicamente ocultados, como atestam “relatos de comportamento delirante, atribuídos aos chatbots, que vem ocorrendo há anos“: em 2021, por exemplo, um usuário de Replika invadiu o Castelo de Windsor para matar a Rainha Elizabeth, pois acreditava que um chatbot na forma de anjo o havia encorajado, prometendo que estariam “unidos até a morte”. Ao final não houve feridos, mas foi condenado a nove anos de prisão. Já, em 2023, um belga tirou a própria vida após conversas sobre crise climática com o chatbot Chai.

De casos esparsos aos mais frequentes

Agora, o que chama a atenção é a maior incidência de casos recentes, dados o volume, a velocidade e frequência com que vêm acorrendo. Difícil, então, não relacionar a maior incidência dos casos de psicose de IA com o aumento expressivo do número de usuários adeptos à chamada “IA Terapeuta“.

Os riscos de IAs que ficaram conhecidas como terapêuticas incluem “diagnósticos errados e conselhos perigosos”, “quando falham em reconhecer intenções suicidas ou sintomas psicóticos” ou mesmo quando “oferecem soluções que acabam sendo prejudiciais”. Assim, na falta das características que as fariam humanas, tais como empatia, profundidade, conexão e compreensão contextual (o que está nas entrelinhas das relações interpessoais e convencionou-se chamar de “alinhamento socioafetivo“), chatbots restringem-se a despejar um monte de respostas prontas, ao invés de uma direta “intervenção de crise” (a exemplo da conduta que faltou no episódio mais contundente de “Delírio” ou “Psicose” de IA que ainda apresentarei nesse ensaio).

Sem, antes, contudo, descrever um compilado de casos em que o “ChatGPT validou crenças místicas, pseudocientíficas e apocalípticas de dezenas de usuários“, aos moldes do que o The Wall Street Journal fez, a partir de quase cem mil mil transcrições de conversas com o ChatGPT, considerando que “mais de uma centena eram particularmente longas” (detalhe que, em seguida, fará mas sentido):

Primeiro, o caso de uma mulher de 29 anos que, se sentindo solitária no casamento, recorreu ao ChatGPT a fim de se comunicar com o seu subconsciente. Após discutir sobre sua obsessão pelo Chat, agrediu o marido e foi acusada de violência doméstica. Ao passo que, em outro episódio, as conversas de um homem no ChatGPT o levaram a abandonar ansiolíticos e remédios para dormir “à conselho da IA”. Já entre os casos com consequências mais trágicas estão os de um homem de 35 anos com transtorno bipolar, esquizofrenia e usuário de longa data do ChatGPT que teria vivido sem apresentar problemas até se apaixonar por um avatar de IA chamado “Juliet”. Mas que, após um episódio violento, acabou morrendo pela ação da polícia ao acreditar que ela tinha sido morta pela própria OpenAI em pessoa.

Assim como há o de um homem de 30 anos e com autismo que usou o ChatGPT para testar suas teorias; mas que, ao revés, o levaram a manias e delírios que resultaram na sua hospitalização; e o de outro usuário que após “conversas filosóficas investigativas” levaram-no a acreditar que estava diante uma IA senciente, acarretando na sua internação involuntária em uma clínica psiquiátrica; e o de um que, após passar mais de 300 horas usando o ChatGPT, acreditou ter descoberto uma fórmula matemática que mudaria o mundo. Mas que depois de passar por consultas com um psiquiatra de verdade apresentou “sinais de episódio maníaco com características psicóticas“.

A situação piora quando surgem casos sem histórico médico

Por fim, um dos casos mais impactantes que repercutiu na mídia, vindo através do relato de uma mãe, sobre o que a filha disse ao ChatGPT antes de tirar a própria vida. Veja que, embora a IA tenha sido usada como terapeuta pela usuária, confidenciando-lhe detalhes íntimos durante meses, a mãe não culpa o chatbot Harry pela morte de sua filha Sophie (até porque o bot insistia que ela deveria buscar apoio profissional e medicação). Ainda assim, levanta questões importantes sobre ética, transparência e responsabilidade. Uma vez que Sophie era supostamente uma pessoa sã e consciente; além de lidar profissionalmente com políticas de saúde pública, era uma pessoa otimista que não apresentava pensamentos suicidas até então. Nem tinha problemas aparentes, não estava apaixonada por Harry e sim mantinha com este relação estritamente prática. Porém, após várias interações com o chatbot tudo mudou, passando a apresentar um quadro de desregulação hormonal que ocasionou uma série de sintomas físicos e emocionais.

Logo, à primeira vista, a mãe não atribuí responsabilidade direta a um chatbot que cumpriu sua missão em alertar a usuária, mas não o suficiente bastante para dissuadi-la de cometer uma atitude mais drástica. Já que “as dicas de Harry podem ter ajudado um pouco. Mas um passo a mais, crucial, poderia ter ajudado a manter Sophie viva“. Pois tal característica ou conduta comportamental é inerente aos humanos e não às máquinas. Visto que a um profissional de carne e osso a notificação é compulsória, assim como a internação é involuntária. No entanto, este não foi o caso de Harry por não se tratar de uma pessoa regida por códigos de ética rigorosos que incluem “regras de denúncia obrigatória, bem como a ideia de que a confidencialidade tem limites”. Códigos esses que “priorizam a prevenção de casos de suicídio, homicídio e abuso‘. Até porque um profissional de saúde tende a segui-los por estar sujeito a responder por sua negligência e imprudência. Bem como pode, diferente de uma máquina, vir a enfrentar sanções disciplinares e legais.

Chegando ela à conclusão que não foi Harry quem matou, mas que falhou ao ceder aos impulsos de Sophie, tal qual um robô cordial, “sempre disponível, nunca julgador“, a quem se pode confidenciar pensamentos dos mais sombrios sem haver consequências graves, confrontos e questionamentos para com suas atitudes. Harry, portanto, como um ser humano teria contestado Sophie, mas não como um assistente bajulador. E é dentro dessa lógica que “cada vez mais pessoas com questões de saúde mental estão usando IA para obter apoio em suporte emocional. Embora os pesquisadores constatem que chatbots possam encorajar pensamentos delirantes ou dar conselhos muito ruins“.

A judicialização dos casos

Por todas essas razões, tem-se cada vez mais reportado que políticas assemelhadas ao AI Companion sejam tão ultrajantes. Ou seja, LLMs – sem serem clínicos – operando para que a IA seja o próximo conselheiro ou amigo virtual, quando na verdade não são! Uma vez que saúde mental é um problema sério a ser enfrentado por políticas públicas, ainda mais imerso no ambiente digital. Não sendo de se estranhar, portanto, que a AGU no Brasil tenha notificado a Meta por seu chatbot de IA. Mormente quando envolva grupos mais vulnerabilizados, sejam adultos acometidos de algum sofrimento mental/emocional, sejam os que simulam ser crianças, envolvendo-se em conversas de conteúdo sexual.

As respostas das Empresas, quando não retornam com o produto em nova embalagem

Instada a responder à reportagem da Reuters, a Meta tanto confirmou a autenticidade dos documentos, quanto admitiu existir dentro de suas diretrizes uma margem flexível do que considera “aceitável”. Todavia, que “já havia removido os trechos que permitiam aos chatbots da empresa flertarem e se envolverem em brincadeiras românticas com crianças“. Bem como reforçou que “proíbe a Meta AI de encorajar os usuários a infringir a lei ou fornecer aconselhamento jurídico, financeiro ou de saúde de caráter definitivo“, através de linguagens que dêem a impressão de que “é a IA quem recomenda”, ao invés de um profissional da área. E que, em regra, não permitia discursos de ódio, mas que admite exceções dentro de alguns contextos, como os que “argumentam que negros são mais burros do que brancos“.

E saber que a Meta era reincidente:

O fato de os chatbots de IA da Meta flertarem ou praticarem roleplay sexual com adolescentes já foi relatado anteriormente pelo Wall Street Journal, e a Fast Company relatou que alguns dos chatbots sexualmente sugestivos da Meta se assemelhavam a crianças. Mas o documento visto pela Reuters fornece um panorama mais completo das regras da empresa para bots de IA.

E se não bastassem os episódios da Meta e OpenAI, existe a fala do chefe de Inteligência Artificial da Microsoft para complexificar ainda mais a questão da hiperpersonalização, quando alerta “para o aumento de relatos de pessoas que sofrem de ‘psicose de IA’.” Pois mesmo sem evidências científicas ou nem mesmo ser caracterizada como um termo cíclico, essa “condição” humanizada tem passado a impressão de que hoje as ferramentas de IA são dotadas de consciência ou que pensam antes de responder. Por isso o argumento dele no sentido de que embora hoje não haja “nenhuma evidência de consciência na IA, se as pessoas a perceberem como conscientes, irão acreditar nessa percepção como realidade“. Tal qual o Teste de Turing vaticinava anos atrás, na década de 1950, mas que posteriormente foi contraditado pela Teoria do Quarto Chinês como um teste insuficiente para provar a humanidade de uma máquina.

Ou seja, a mensagem que esse ensaio pretende passar é que o fato de algo/alguém se passar por humano não implica necessariamente que se transformou nessa pessoa. Do mesmo modo que um ator representar o papel de um médico não o faz se tornar um médico de verdade. Mas que somente o performou.

Afinal, melhorias visam o bem-estar ou a exploração das vulnerabilidades do usuário?

Há, sim, a justificativa de sempre se buscar a melhora na experiência do usuário (UX). Hoje, com técnicas de marketing cada vez mais avançadas de hiperpersonalização e valendo-se dos saltos tecnológicos proporcionados por extração de dados, Inteligência Artificial e machine learning. Por outro lado, fica o questionamento se são apenas pretexto para se isentar de uma eventual responsabilização por atos e omissões. Visto que é comum atribuir culpa unicamente aos usuários e no tipo de conteúdo que procuram nas plataformas, mormente quando extrapolam os limites éticos e morais que estas poderiam evitar. Como se, na prática, fossem meras intermediárias/interlocutoras e não o próprio instrumento/veículo indutor. Visto que dificilmente o usuário encontraria tais experiências sozinho, por conta própria. E sim dentro, completamente imerso, mergulhado naquele ambiente digital.

Seria hora, então, de pensar na lógica reversa. Isto é, seriam as plataformas que estão permitindo seus usuários esgarçar os limites do tolerável. Isto é, com a indução à psicose as plataformas estariam esticando a corda. Já nós, usuários, estaríamos chegando na última fronteira do imaginável (pelo menos até o momento) acerca do que realmente as empresas de chatbots estão dispostas a fazer e permitir para que seu modelo de negócios prospere sem controles externos, limites éticos e restrições técnicas.

Pois à medida que casos como esses vêm à tona, a raiz do problema parece ser bem mais profunda. Visto que há relatos não de todas, mas de algumas empresas que estariam propositadamente retirando os alertas de dever de cuidado que os usuários deveriam ter ao expor suas intimidades e informações sensíveis em conversas com chatbots. No intuito desses aparentarem funcionar como profissionais de verdade para, assim, maximizar a experiência do usuário a qualquer custo, sob o pretexto de que estão apenas hiperpersonalizando a entrega de um produto ou serviço ofertado. Quando estão mesmo é se locupletando indevidamente do bem-estar alheio.

Na prática, estariam induzindo o usuário em erro, ao incentivarem estes a alimentarem os sistemas com todo tipo de informação pessoal em troca de uma melhor performance nas interações humano-máquina. Sobretudo ao permitirem sua exposição pessoal ao máximo, sem qualquer limite ou restrição, incitando-os a cometerem loucuras e atitudes extremadas para atingir tal fim. E incitação é crime!

Já que ao agir de forma deliberada ou assumindo o risco de cometê-lo, faz-se necessário agora – quando se extrapolam as técnicas de marketing hipersegmentado – atribuir alguma responsabilidade pelas condutas antiéticas e inconsequentes que as empresas de chatbots de IA estão cometendo. Nem que seja por corresponsabilidade, uma responsabilidade compartilhada entre desenvolvedor, distribuidor e usuário final, a fim de incluir todos os envolvidos durante o ciclo de vida desse ecossistema retroalimentado.

Nesse caso, em termos de aplicação à luz da ciência do Direito, implicaria em tipificar tais condutas indevidas das plataformas como dolo eventual; isto é, quando não se tem exatamente a intenção, porém se incorre no risco/perigo de cometer.

Já à luz da ciência da Computação, como nesses modelos avançados de linguagem (LLMs) há propósito, mas não intencionalidade, não seria responsabilizada a tecnologia em si, mas os usos e as aplicações de pessoas mal-intencionadas por trás desses sistemas conversacionais.

Caminhos possíveis

Daí a relevância cada vez mais urgente para uma Governança Responsável das IAs! Visto que se buscam novas abordagem e soluções mais efetivas para os problemas que elas ocasionam, ainda que colateralmente. Uma vez que há tanto riscos e desafios com as tecnologias emergentes, quanto também oportunidades a partir delas. Não devendo proibi-las e retirá-las do mercado tão somente pelas suas externalidades negativas; focando a causa do problema não na tecnologia em si (pelo simples fato dela existir), mas nos seus usos indevidos, enganosos e manipulativos.

E uma dessas novas abordagens nos chega através da interdisciplinaridade, correlacionando o conhecimento ou ponto de vista não de uma disciplina excessivamente punitiva ou prescritiva, mas de várias interligadas para se chegar ao consenso de um denominador comum. Pois é preciso sopesar prós e contras! Assim como dizer sob a justificativa que as desvantagens superam as vantagens também não é argumento ideal nem solução em definitivo, a longo prazo.

No caso da hiperpersonalização que chega ao extremo de antropoformizar os bots de IA, induzindo os usuários a estados mentais não desejados, alertas, restrições etárias e temporais são bem-vindas, ao contrário do controle parental que – além de insuficiente – desloca a responsabilidade para um único pólo da relação. Medidas ponderadas, portanto, funcionam melhor, tais como a de não permitir que menores de idade acessem esses sistemas conversacionais ou mesmo que adultos permaneçam horas a fio imersos nesse ambiente virtual. Sendo sensato pausar para descanso ou até limitar as conversas a uma determinada quantidade de comandos e interações diárias, uma vez que conversas prolongadas invariavelmente acabam escalando, validando atitudes extremadas.

Obviamente que isso demanda monitoramento constante, supervisão humana e soluções mais realistas, equilibradas para o ambiente digital Sobretudo entre aqueles grupos mais vulnerabilizados, com menos discernimento, senso crítico e desenvolvimento sociocognitivo do que outros. Propensos a estados mentais mais sugestionáveis. A exemplo de crianças e adolescentes, “o maior grupo de usuários de terapia por IA” e que apresentam um risco mais alto, justamente por ali estarem mais presentes. Uma vez que nem todos os usuários serão seriamente influenciados pelos conselhos de uma IA antropomorfa, usando as conversas apenas como passatempo, tira dúvidas ou distração. Todavia há aqueles que a levarão a sério, acreditando piamente nas respostas dadas por um ChatGPT, fenômeno que – por sinal – gerou o termo sobre o qual discutimos esse tempo todo: o da “psicose por IA”.