Por que países, como a China, querem agora regular as inteligências artificiais antropomorfas, tratando-as como uma questão de interesse nacional, orientada por critérios de (ciber)segurança, ética e responsabilidade? Sim, não estou mais sozinho nessa tese!

Entre as tendências tecnológicas para 2026 estão desde robôs e companheiros artificiais a IA híbrida e dados preditivos. Sobretudo, a personalização em tempo real, de ponta ponta (desde o desenvolvedor até o usuário final, durante todo o ciclo de valor da análise de dados, aprendizado de máquina e IA) para criar experiências únicas e altamente individualizadas para cada cliente. Um cenário já observável anteriormente no ambiente corporativo, mas que se intensificará no ano que se inicia.

Estratégia esta que deve orientar todo o processo de decisão, inclusive a que vem direcionada para o uso pessoal e uma melhor experiência do consumidor (CX), dada a expansão dos agentes virtuais que passam agora a se antecipar e prever o comportamento humano. Reforçando a tendência da integração entre pessoas, o uso estratégico de dados, automação e IA em escala como o ponto crítico do(s) próximo(s) ano(s), funcionando tudo de forma mais orgânica e integrada do que antes, a ponto de homem e máquina virem a se tornar um dia em um ser indissociável. A partir dos traços da IA que, não sendo mais visíveis ou detectáveis, fundindo-se à matéria corpórea, acabarão “normalizando” esse processo.

Fala-se, então, em “ajustar operações ao vivo, conforme o humor, o perfil e a probabilidade de comportamento do cliente” como a nova etapa ou padrão da transformação digital, agora de forma mais rápida, integrada e orientada por dados, visando alcançar outro patamar de eficiência e experiência.

Contudo, sob um olhar em retrospectiva, 2025 foi o ano em que a Indústria da tecnologia profetizou o salto definitivo dos chatbots de IA para os agentes autônomos de forma irrestrita, independente, com pouca interferência ou nenhuma supervisão humana. E por que agora? Porque nos encontramos nesse momento de rápida expansão das IAs voltadas para o uso pessoal junto ao mercado consumidor, no qual deixam simplesmente de executar tarefas generalistas e responder a comandos/perguntas específicas elaboradas pelos usuários para começar também a agir e decidir sozinhas de ponta a ponta, por conta própria ou até tomando o nosso lugar “como se fossem gente“, pois “supostamente mais próximas da forma como humanos trabalham“. Passando-se por nosso preposto, consultor, especialista ou conselheiro para todo tipo de conversa e assunto.

A promessa estava, então, nesse “assistente” virtual que, exterior ao ambiente do usuário e agora integrado profundamente a todo ecossistema TIC (informação e comunicação), passa a dispor também dos recursos de tecnologias-chave como IA, machine learning e análise dos dados das empresas, focado em automatizar tarefas avançadas no e-commerce, atendimento ao cliente e marketing digital através de chatbots inteligentes e mecanismos de recomendação em serviços financeiros, de saúde, educação, varejo e entretenimento.

Sabe quando aplicativos, páginas dinâmicas na web e programas de fidelidade, através de seus agentes e assistentes virtuais, não lhe dão trégua, notificam a todo instante e te chamam por seu nome como se fossem humanos? Trata-se desse fenômeno!

Pois enquanto que a personalização tradicional é reativa e baseada em dados anteriores, a hiperpersonalização é uma estratégia de negócios mais profunda, dinâmica e proativa que utiliza tecnologias preditivas avançadas para oferecer experiências, produtos ou serviços altamente personalizados, como aquele que acontece em marketplaces e grandes plataformas. Porém, com a diferença de não se basear apenas no contexto, no padrão de compras, dados demográficos, histórico de navegação e número de cliques, mas também na análise comportamental e das preferências individuais dos clientes.

Esse “nível de sofisticação” permite a análise dos dados do cliente para prever comportamentos ou preferências futuras, utilizando-se até mesmo de dados psicográficos para tal (como valores e suas motivações para compra). Tal capacidade “possibilita que as empresas antecipem as necessidades dos clientes antes que sejam expressas explicitamente, tornando a hiperpersonalização eficaz na criação de engajamento significativo, na geração de conversões e na fidelização do cliente“.

Todavia, para que a experiência da hiperpersonalização seja realmente bem-sucedida é preciso a contrapartida de uma conjunção de fatores, tais como: a) insights em tempo real para “adaptar as interações com o cliente de forma dinâmica” e “permitir recomendações instantâneas e personalizadas de produtos”. Mas, para tanto, isso depende da captura e análise de dados que priorize também salvaguardas, tais como: b) a privacidade e a segurança dos dados do cliente; c) testes e otimizações constantes; d) a incorporação do feedback dos usuários; e) e, por fim, o uso de IA e aprendizado de máquina de forma mais ética e responsável, combinando personalização com contexto (ou seja, aquilo que está subentendido nas entrelinhas, algo que não facilmente perceptível por modelos probabilísticos).

Da automação tradicional até a chegada da hiperpersonalização:

No entanto, findado o ano, as coisas não aconteceram bem como o esperado, revelando – inclusive por memorandos internos das empresas – que a transição não foi imediata nem tão bem-sucedida assim, já que ajustes ainda precisavam ser feitos para se chegar até lá: não apenas por ainda não ter alcançado a autonomia irrestrita, mas porque as alucinações dos modelos de IA continuam apesar de atualizações sucessivas. Visto que falhas e erros são parte inerente aos sistemas, e não exatamente uma anormalidade ou problema nos LLMs. Principalmente em tarefas multi-etapas onde qualquer pequeno deslize ou imprecisão “invalida toda a árvore da cadeia decisória“. Há explicação, portanto, e ela é matemática!

Sobretudo que “os agentes de IA são úteis ainda em tarefas estreitas e ambientes determinísticos”, mas “não funcionam bem fora de ambientes controlados”, visto que “esbarram em limites” e restrições técnicas profundas no que dizem respeito a confiabilidade e contexto. Aspectos estruturais, entretanto, que foram ignorados no ápice de seu hype por meio de intensa propaganda midiática, via marketing digital direcionado a determinados segmentos sociais (uma publicidade do tipo segmentada que já não é muito bem vista da perspectiva ética, sobretudo quando se vale de padrões comportamentais que geram gatilhos emocionais).

A IA que, agora, está mexendo com a cabeça das pessoas:

Em outras palavras, é chegada a vez de uma IA que não nos faz muito bem, afetando a nossa saúde física e mental, já que mexe com a psiquê das pessoas. O que, segundo a Psicologia, inclui não só a mente, mas o ego, a personalidade e o comportamento, fora as experiências e a forma (consciente ou inconsciente) como encaramos e nos adaptamos ao mundo ao redor. Trata-se, agora, então, de uma experiência muito mais dinâmica, por inferir o que o consumidor mais deseja, antes mesmo de se manifestar. Mas, ao mesmo tempo, mais profunda e desalinhada com a sua função social, visto que sabedoras disso, é permitido às empresas de tecnologia mais controle e monitoramento do que em outrora.

Principalmente quando as IAs que temos hoje, sobretudo a generativa de textos, vídeos e imagens sintéticas, são comumente direcionadas para a disseminação de conteúdos falsos, desinformação, deepfakes e raigebait. O que não colabora muito para a nossa percepção da realidade, notadamente em contextos críticos como democracia e estado de direito.

Assim, no campo político, deepfakes hiper realistas ou são feitas para enganar a percepção pública, manipular a intenção de voto, ou para humanizar, “personificar”, tornando mais acessível e simpática” a imagem de um determinado candidato. Usando a IA para se conectar melhor com eleitores do que conseguiria com as campanhas tradicionais. Afinal, extrair o que se conversa nos chatbots de IA garante dados preciosos sobre as reais intenções e necessidades dos cidadãos. Servindo de ferramenta velada de vigilância.

Ou para prestigiar a desinformação em áreas sensíveis, como a da saúde. A exemplo, segundo notícias recentes, de alguns resumos de IA (AI Overviews), justamente aqueles em destaque e que aparecem no topo dos resultados da pesquisa, forneciam informações de saúde falsas e imprecisas, colocando os usuários em situações de risco real que “podem levar pacientes a ignorar sintomas graves ou abandonar tratamentos essenciais“.

Assim como o caso da IA “que ignorava fatores como idade, sexo e etnia ao explicar resultados de exames de sangue“. Já que, “sem esse contexto, números que pareciam normais na tela poderiam mascarar doenças hepáticas severas em determinados perfis de pacientes, o que gerava uma falsa sensação de segurança“.

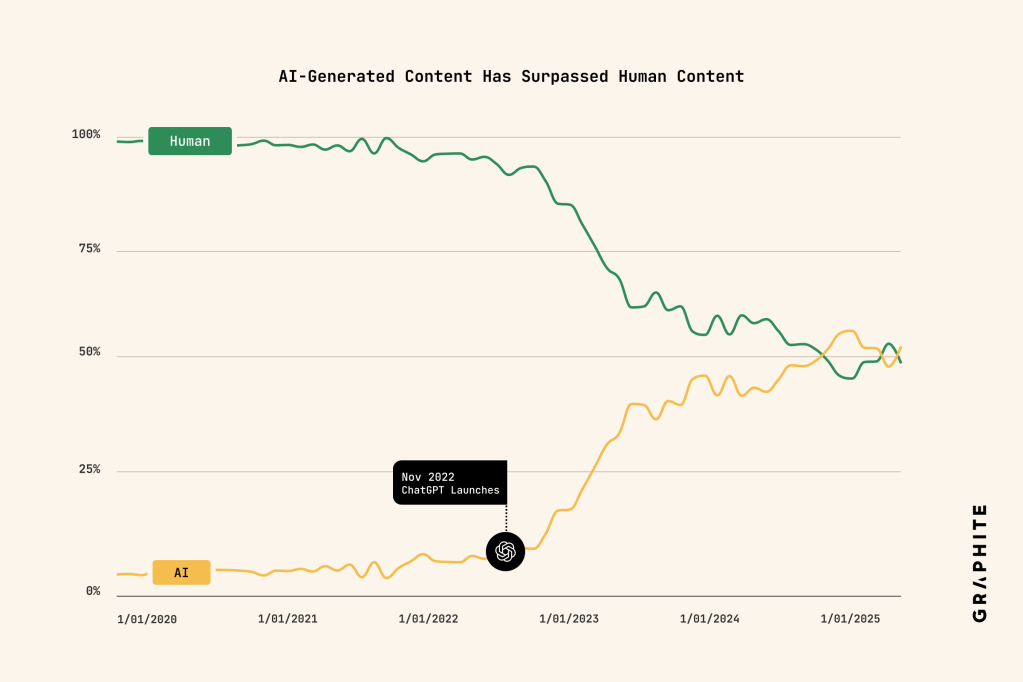

E por que episódios como esses (ainda) acontecem? Já que os LLMs reproduziram ou copiaram as informações (muito mal, por sinal) de textos produzidos originalmente por humanos. E não porque “aprenderam” sozinhos e se tornaram “especialistas” de uma hora para outra! Fenômeno esse conhecido como “memorization” e que envolve questões de infração da proteção de direitos autorais (copyright), mas que empresas de IA negam que ocorra em larga escala, afirmando que “não há cópia dos dados de treinamento — sejam textos, imagens ou outros formatos” de distintas fontes/datasets. No caso, a reprodução não consentida de palavras, trechos e até de obras e livros inteiros, como Frankenstein, 1984 e O Apanhador no Campo de Centeio.

Algo que um dia atingirá “um teto”, qualitativamente falando, segundo parte da comunidade científica, em um contexto de internet cada vez mais poluído por conteúdos gerados por IA, dada a escassez de textos de qualidade ainda disponíveis para o seu treinamento. Fazendo com as empresas não possam mais se valer do Fair Use como argumento para se defender nos tribunais contra as acusações de cópia e pirataria. Atingindo o limite de escalabilidade, portanto! A ponto de Sam Altman vaticinar que a Indústria de IA “acabou” se não dispuser mais de dados livres para treinar seus modelos.

Um reconhecimento não apenas das restrições técnicas e limitações cognitivas das redes neurais profundas (LLMs), mas também da necessidade de se buscar um caminho alternativo ao modelo de IA que a Indústria está atualmente investindo. A despeito dos sinais de alerta e red flags. A onda de reações negativas (backlash) tende a continuar, então, mas não por falta de avisos.

Apesar dos alertas, estamos mais dependentes do aval de uma IA:

Ainda que “não caiamos na armadilha do antropoformismo” das máquinas já consideradas “inteligentes” por parte da indústria, é preciso estudar o assunto com mais profundidade, tratando o fenômeno crescente da (hiper)personalização como uma realidade da qual não há retorno. E, a nós, só nos resta “correr atrás do prejuízo”! Uma vez que a novidade (uma IA que supostamente sabe, compreende o mundo, performa, faz tudo por e até melhor do que nós) não só povoa o imaginário coletivo, como também já ganhou o gosto popular. Pois está comodamente ao nosso alcance através dos smartphones, funcionando os meios de comunicação digital como longa manus ou extensão híbrida do corpo humano, ao parafrasear McLuhan.

Por outro lado, normaliza-se cada vez mais essa indissociação entre IA e humanos. Isto é, uma via de mão dupla onde robôs se humanizam, enquanto o comportamento das pessoas também está se robotizando. Basta abrir um aplicativo, moldar a personalidade desejada no chatbot, inclusive designando-lhe um estilo ou uma estética mais crítica ou condescendente para evitar atritos, julgamentos, conflitos. Temos, então, avatares dando vida a esse novo personagem híbrido. Ou até mesmo ao nosso clone digital para assumir o nosso lugar em reuniões agendadas ou em testes clínicos.

Certamente os tecnicistas não verão a escalada da automação rumo à hiperpersonalização como um problema em si, e sim uma inovação tecnológica positiva capaz de nos fazer delegar tarefas repetitivas, de baixa complexidade e capacidade cognitiva para as máquinas, a fim de que nos dediquemos a atividades mais prazerosas do que meramente viver para trabalhar. Tornando-o até mesmo opcional e desnecessário, bem como forjando um cenário onde até o dinheiro será irrelevante. É assim como Elon Musk prevê o futuro do trabalho para os próximos anos, quando “afirma que sistemas autônomos vão assumir tarefas humanas, em meio ao avanço de projetos da Tesla e da xAI nas áreas da robótica e Inteligência Artificial“. Estimando que a substituição possa ocorrer já nas próximas décadas.

No entanto, como isso será possível? Pagar contas, comprar comida, sem precisar trabalhar? A resposta, segundo Musk, é que “milhões de robôs cuidarão de tudo!” Na prática, contudo, o objetivo dessas IAs não é exatamente a melhora da prestação do serviço e entrega do produto. E sim ser tornarem mais atrativas e as empresas fidelizarem o cliente no intuito de não perdê-lo para a concorrência. Assim, estudos atestam que IAs assistentes que hoje se comportam como nós e imitam a personalidade humana são projetadas para concordar e sempre agradar, criando vínculos afetivos que causam a supressão gradativa de nossa autonomia e, por conseguinte, gerarão maior dependência física, psicológica e emocional. Inclusive cognitiva.

HITL ao invés da IA totalmente autônoma:

Para um grupo de especialistas, declarações como a de Musk representam uma visão equivocada – ou mesmo ultrapassada – de futuro por não reconhecer o real valor das pessoas no mercado, equiparando-as ao rendimento das máquinas que, este sim, pode ser “quantificável, replicável, escalável” como ocorre no mundo corporativo. Transpô-la para o mundo real dos humanos que é o desafio atual!

Por outro lado, emerge o conceito de Human-in-the-Loop (ou IA com interação humana) como contraponto a essas ideias superestimadas, pelo menos no atual estágio de uso, aplicação e desenvolvimento da tecnologia. A vantagem no HITL está na abordagem híbrida, em ser um tipo de Inteligência Artificial que não compete, e sim colabora, integrando a inteligência humana ao aprendizado de máquina (machine learning – ML) a fim de aprimorar os processos decisórios.

E que, portanto, se diferencia dos sistemas de IA totalmente automatizados, o que é crucial para lidar com cenários complexos ou casos extremos em que a IA é passível de falha, uma vez que a automação completa se revele insuficiente. Assim, a HITL é particularmente benéfica em situações que exigem transparência, pois permite a supervisão humana ativa nas fases de treinamento e tomada de decisão do ML, criando um ciclo de aprendizado contínuo. Seja fornecendo feedback e conhecimento especializado para aprimorar a precisão e a confiabilidade das máquinas de forma mais ética, segura e responsável em áreas de alto risco estratégico, como educação, saúde, transporte e finanças.

Pois bem, a vantagem do hibridismo está aí, em integrar, aproveitando tanto o julgamento humano quanto a eficiência da máquina, a exemplo dos carros autônomos e alguns tipos de caixas eletrônicos que têm certa dificuldade de entender e interpretar corretamente dados visuais, fazendo com que sob a influência humana sejam mais seguros e confiáveis do que quando operam completamente sozinhos.

Mas que, na prática, ainda representa um problema de natureza estrutural que implica em questões de “compliance, risco e auditoria”, pois é de costume fazer com que o agente execute, mas o humano só apareça para aprovar no momento final. Acontece que isso se torna um gargalo operacional, já que o julgamento/elemento humano entra tarde demais nesse processo, “quando as decisões já foram tomadas e os caminhos traçados. Cenário em que “a maioria dos sistemas falha por cair em um desses extremos: ou são “estruturas rígidas demais, com regras fixas que não se adaptam a novos contextos”, ou há “autonomia irrestrita, onde o agente decide tudo até que algo dê errado”. Porém, em nenhuma das duas hipóteses há escalabilidade.

Ainda assim, a verdadeira missão do HITL é fazer com que pessoas e máquinas não conflitem, e sim contribuam para incrementar “a capacidade de aprendizado, a resolução de problemas ou quaisquer outras características tipicamente associadas à mente humana“.

E dadas essas ponderações, veremos adiante se é acertada ou não a decisão desse modelo de negócios em se concentrar somente na estratégia de aumento dos modelos e das capacidades computacionais de IAs autômatas e personalizadas que interagem semelhante a humanos. Não na tentativa de inovar e buscar alternativas aos problemas existentes que já estão surgindo para os usuários a partir da substituição humana, mas na meta obsessiva das empresas em liderar e querer ser a principal distribuidora de um único produto no mercado. O que pode ser questionado também do ponto de vista da concentração e do abuso de poder econômico: como é o caso da disputa atual entre os chatbots conversacionais da OpenAI (GPT) Google (Gemini), Antrophic (Claude) e xAI (Grok). Sem falar da concorrência chinesa com seus modelos mais baratos, otimizados e de código aberto que, em tese, dependerão de menor infraestrutura e capacidade computacional que os ocidentais. Por serem mais sustentáveis (ambiental, estrutural, comparativamente falando).

ChatGPT x Gemini: radicalizar na personalização para vencer a concorrência

Hoje aventa-se a possibilidade da Google ter ultrapassado a OpenAi na corrida pela liderança do mercado de IA. Depois de ter largado atrás (algo questionável, a depender do critério de aferição utilizado) e dos sucessivos escândalos envolvendo a sua concorrente nas primeiras disputas judiciais entre usuários e a hiperpersonalização do ChatGPT. Inclusive pelas falas controversas de seu CEO. Podendo-se dizer que, após um período de alta/hype, a OpenAi atravessa agora um período de baixa: mais por culpa própria, divisões internas, erros de cálculo e o seu mal aproveitamento no gerenciamento de crises. Nada que não possa ser revertido após o lançamento de uma nova versão. Aguardemos…

Por ora, enquanto a Google investe no Gemini para alcançar a liderança global da IA, a OpenAI aposta na radicalização do seu modelo. E, desta feita, se aproxima de um ponto de inflexão quando apela e dá a impressão – falaciosa, por sinal -, que não conseguiremos mais agir e decidir sozinhos, passando a depender e consultar tudo antes às IAs. Isto é, a de que estamos incapacitados, uma vez que mais carentes, confusos ou indecisos, somos mais dependentes do que nunca de uma IA!

A exemplo da declaração de Sam Altmam de que não saberia mais como criar seus filhos sem a ajuda de uma IA. Tarefa essa que, segundo ele, seria impossível sem recorrer ao seu chatbot. Ou seja, criando um problema quando em gerações anteriores não existia. Ao melhor estilo “criar dificuldades para vender facilidades”.

Outro exemplo é o da função Copilot da Microsoft: uma AI Companion configurada de fábrica para “informar, resumir, entreter e inspirar,” mas que, quando o aplicativo é aberto, já não deixa o usuário fazer muita coisa sozinho/por sua conta, sendo preciso desabitá-la para tanto (quando isso é possível na prática).

É preciso, então, primeiro desmistificar a infalibilidade dessas “IAs antropomorfas” que estão nos incutindo para, depois, enfrentar a questão da sua onipresença. Pois as consultas pessoais têm variado bastante, em diferentes setores, sobretudo no uso de chatbots no Brasil que está acima da média global: desde as mais inofensivas, como aprender algo novo, saber a previsão diária do tempo antes de sair de casa, como traçar a menor rota por meio de um aplicativo de transporte ou qual o melhor roteiro para uma viagem turística, até as tarefas que envolvem maior complexidade do ponto de vista moral e ético, a exemplo do conteúdo que é ou não relevante na internet, em qual notícia confiar ou em quem votar nas próximas eleições.

Uma vez que, quando a internet for dominada por robôs, as pessoas passarão a não confiar em mais nada no que aparece por lá. Nem mesmo em vídeo, antes prova cabal de que aquilo era verdade, já que hoje pode ser adulterado, manipulado pela edição ultra realista de voz e imagem. A exemplo de um dos registros na captura de Maduro, no que pode ser considerada das primeiras imagens sintéticas de IA difundida globalmente em 2026. Quando pouca gente se preocupou em checar antes de compartilhar, não se importando com os fatos, mas com a “realidade desejada”.Logo, o problema maior hoje em dia “não é a IA estar errada, mas convencer e dar a impressão que está certa”! Uma crise antropológica, portanto, que se instaura nos campos da credibilidade e confiança pública!

Estamos, então, diante de uma tecnologia que mexe com a cabeça das pessoas e inclusive influencia na intenção de voto após o usuário conversar com um chatbot. É a IA “dizendo”: não se dê o trabalho, deixe que eu penso, interpreto e decido por você! O que é preocupante, sobretudo quando a própria indústria reforça essa dependência maquínica (seja física, mental, emocional e até cognitiva) de que hoje, na era das IAs hiperpersonalizadas, precisamos consultá-las previamente para obter o seu “aval” (entendido aqui no seu aspecto amplo, tal qual como funciona em uma validação, aprovação, em forma de consentimento e até na de argumento de autoridade, de modo autônomo, sem precisar da consulta a outro agente superior, de preferência humano).

Quando, por meio de estudos especializados, já se sabe que “chatbots acertam menos da metade dos diagnósticos quando operados por pessoas sem formação técnica“, havendo relatos de pessoas que, sob “orientação” do ChatGPT, conseguiram identificar um bloqueio arterial grave depois de insistir por um exame médico mais aprofundado. Já em outro, o paciente “recebeu alarme falso de possível tumor, também a partir da análise feita pela IA”.

E, é assim que, a partir dessa nova dinâmica de co-dependência humano-máquina que milhares de pacientes estão, dentre outras coisas, “adicionando registros médicos completos em sistemas de inteligência artificial como o ChatGPT para obter respostas imediatas sobre sua saúde. Essa prática, que inclui o compartilhamento de exames laboratoriais, laudos, imagens e históricos clínicos, vem crescendo à medida que as pessoas buscam entender sintomas e diagnósticos de forma rápida e autônoma“. Muitas vezes motivadas pela alta demanda e alto custo da consulta à profissionais de verdade. Porém, sem se importar muito com a precisão limitada e falta de proteção legal. Questões, enfim, sensíveis relacionadas ao sigilo médico, à privacidade e proteção de dados a quem confiamos diariamente às máquinas.

Caso Sewell Setze e outras denúncias alarmantes:

Vimos que entre as tendências para 2026 e os próximos anos estão desde robôs e companheiros artificiais a IA híbrida e dados preditivos. Alavancando a automação em tempo real, de ponta ponta, como carro-chefe para criar experiências únicas para os indivíduos. Acontece que algumas dessas experiências personalizadas têm sido desastrosas! Não para todos, para determinado público mais vulnerável que os demais, como mulheres e menores de idade.

E por não alcançar a maioria dos usuários, mas somente alguns, a resposta das empresas, entretanto, não tem sido lá muito satisfatória! A despeito de um contexto em que, ao invés de negligenciada, a proteção desses grupos deveria ser reforçada. Posicionamento este, aliás, da nossa ANPD – Autoridade Nacional de Proteção de Dados quando prioriza crianças e adolescentes na atualização de sua agenda regulatória para 2026 e 2027.

Assim, em vez das empresas virem a público e fazer o mea culpa, reconhecendo que talvez os LLMs não sejam o melhor caminho para a autonomia irrestrita, quiçá uma IA Geral, ou mesmo retirar o produto do mercado e corrigi-lo de modo definitivo, a fim de impedir que essas falhas aconteçam novamente, acontece exatamente o contrário. Ou seja, insistem em manter o serviço em operação (ainda que na forma de um protótipo ainda imperfeito ou inacabado). Seja através de uma nova versão do modelo antigo, de sucessivas atualizações (4.5, 5.0, 5.1), seja reduzindo a audiência através de controle parental, modo adulto e o somente liberado para assinantes.

Em resposta, empresas como o xAI falam, portanto, que proíbem (limitam e restringem a criação desse tipo de material ilegal), mas na prática a função é facilmente driblada e continua disponível para quem paga! Pois as medidas de contenção implementadas, a exemplo dos sistemas de aferição de imagem (RF) e idade, são insuficientes para a proteção integral, já que não impedem, p. ex., o acesso de menores a jogos inadequados, como é o caso atual envolvendo o Roblox (o que faz questionar se são crianças mesmo protestando, e não adultos se passando por elas; aliás, outra prática coibida).

Em suma, estão, de novo, “criando dificuldades para vender facilidades”. Não por acaso o IDEC, Instituto de Defesa do Consumidor, está pedindo a suspensão do Grok no Brasil pela violação sucessiva de direitos de crianças, adolescentes e mulheres, o maior alvo de geração de imagens sexualizadas, pornográficas e de nudez não consentidas por meio de sua ferramenta de IA que já vem integrada à plataforma.

Não se tratam de casos isolados, mas fazem parte de uma reação internacional contrária à essas práticas reiteradas globalmente (não por uma, mas boa parte das empresas de IA). E que, além da Índia, inclui países europeus como Reino Unido e França. A exemplo de seu bloqueio na Indonésia, lugar há bastante tempo alvo de desinformação através de deepfakes fofinhas e vídeos na forma de clones hiperrealistas no contexto eleitoral. Visto que a sua “humanização” não as torna menos inofensivas, pelo contrário! Lembrando que, em 2024, o TSE aprovou resolução que “proíbe uso de inteligência artificial para criar e propagar conteúdos falsos nas eleições“, “vedando o uso de robôs de IA que simulem conversas com candidatos ou pessoas reais“.

1. Já na área médica, dentre os de repercussão recente, destaca-se o Caso Sewell Setzee por ser um dos primeiros a chegar um acordo para encerrar o processo (mas cujos termos ainda não foram divulgados). Dessa vez envolvendo a Google e a Character.AI, uma startup de Inteligência Artificial, após a família alegar na justiça dos EUA a produção de danos psicológicos aos usuários em mais um caso de suicíd3o de adolescente ligado aos chatbots.

Este e outros processos em andamento deverão moldar o campo da responsabilidade da IA, ganhando notoriedade por chegar ao ponto de comprometer a vida, a saúde e a integridade física e mental do indivíduo. Mas sem antes haver contestação, pois ainda não estão claras a extensão, a relação de causa e efeito, nem qual tipo de responsabilidade acarreta (se objetiva, subjetiva ou ambas). Isto é, até que ponto as empresas de IA devem ser responsáveis pelos danos (e se precisam mesmo arcar com os custos e indenizar as vítimas e suas famílias) em incidentes que envolvam interações emocionais com uma máquina por mais avançada e sofisticada que seja.

Embora saiba-se hoje que chatbots de IA deixaram de ser meras ferramentas auxiliares e foram alçados ao status de “companheiros íntimos digitais”. Assim, quanto mais humanas se assemelham, mais conquistam a confiança dos usuários, recebendo uma enxurrada de detalhes pessoais que vão desde rotinas diárias a confissões de medos, inseguranças e tomada de decisões delicadas. Isso a fim de chegar a um diagnóstico o mais preciso possível, o que nem sempre há garantias de acontecer. Essa “nova dependência” não só amplia velhos riscos da internet, como também cria incentivos para que se monetizem essas conversas via aumento da publicidade, assim como do próprio treinamento dos grandes modelos de linguagem (LLMs) para que performem de modo mais natural e realista.

Logo, onde você procura saber e a “quem” confidencia detalhes íntimos pode não ser o canal/lugar mais indicado. Como no caso do Claude, Gemini e ChatGPT, por exemplo, onde o usuário, ao usar certas palavras-chave no prompt (comando), denunciam muitos de seus planos e intenções mais profundas e particulares aos chatbots de IA. Pois essas informações deveriam, porém não estão totalmente cobertas por sigilo e podem até ser comercializadas. Assim, perguntas sobre consumo de dorgas, ‘ab0rt0, HIV, imigração, traição”, detalhadamente catalogadas por “gênero, idade, renda e localização” podem ser monitoradas através da coleta por extensões do navegador que a maior parte das pessoas instala sem saber o que está exatamente autorizando.

Essa tendência de se usar chatbots de IA no dia a dia para todo tipo de pergunta/consulta se aprofunda a cada novidade ou nova versão de um modelo antigo. A experiência pessoal se torna cada vez mais personalizada em busca de um realismo questionável e isso pode beirar o limite do radicalismo. Como parece ser o caso do ChatGPT Health, introduzido no Brasil em 7 de janeiro de 2026. Uma versão específica do GPT voltada exclusivamente para questões de saúde. Segundo palavras da empresa: uma experiência dedicada a reunir informações sobre saúde e bem-estar, já que a “inteligência do ChatGPT” pode ajudar o usuário a se informar, se preparar e seguir com mais confiança ao cuidar da sua saúde.

Vale lembrar que a OMS – Organização Mundial de Saúde não o desabona como instrumento-meio (mas não fim, com o objetivo de substituir a análise de um especialista ou profissional de verdade). Por isso recomenda cautela para essas ferramentas com “linguagem humana”!

Sugerindo, então, que existe um lado positivo na oferta desse tipo de produto/serviço ao auxiliar na triagem clínica, na sugestão de hipóteses diagnósticas e indicação de exames. Uma vez que com a escassez global de médicos para cuidado, atenção primária e pré-avaliação clínica— particularmente em contextos com recursos materiais e imateriais limitados, como falta de empatia e longas filas de espera, — os LLMs têm o potencial de apoiar e aprimorar a conscientização dos pacientes sobre primeiros cuidados e autoconhecimento sobre seu corpo.

Assim como ajuda a “promover o engajamento e o protagonismo do paciente” com relação aos seus direitos e deveres. Visto que “soluções como o ChatGPT Health ampliam (i) o acesso à saúde, (ii) à informação e (iii) à educação em saúde“. Mas, por outro lado, o ganho em eficiência na área da saúde “só vira valor quando vem acompanhado de segurança do paciente, conformidade ética e regulatória e responsabilidade jurídica“.

Logo, é “irresponsável celebrar a novidade sem questioná-la”, sobretudo diante da possibilidade de dependência e desumanização! Pois o primeiro contato com a nova funcionalidade pode passar uma falsa sensação de segurança para quem o consulta! Assim como o seu uso prolongado sem estabelecer limitações temporárias e contextuais. E esses alertas não significam restringir a inovação! Pelo contrário, visam a garantir segurança jurídica e previsibilidade nos negócios (sobretudo para as empresas, a fim de resguardá-las de possíveis judicializações).

2. O ChatGPT, por ser o mais popular, acaba sendo o mais usado para esse tipo de consultas (pelo menos até o momento presente). E, naturalmente, o mais visado quando algo dá errado ou sai fora do script (ou conjunto de instruções). Especialmente quando se almeja atingir uma IA que pareça mais natural e humana! Motivo até para ações judiciais e divisões internas!

Como no caso Adam Raine, adolescente de 16 anos cuja interação prolongada com o chatbot teria contribuído ou encorajado o seu suicíd3o, vide o resgate do histórico das conversas por sua família. O que virou motivo para processo nos EUA, acusando tanto a companhia quanto o seu co-fundador de negligência após o usuário receber incentivos em mensagens privadas para redigir a carta de despedida e planejar o ato em si. Dada a má repercussão, foram prometidas mudanças para evitar que a Inteligência Artificial contribua de alguma forma para o aumento das crises de saúde mental entre seus usuários.

Todavia, em contrapartida, OpenAI alega que “o ChatGPT é inocente” (em mais um caso de antropomorfização da IA), uma vez que Adam teria violado os termos de uso, não se responsabilizando pelo conteúdo gerado pelo chatbot. Sob o argumento de que “o incidente foi resultado de ‘uso indevido, não autorizado e não intencional’ da ferramenta“.

Lembrando que a família processou a empresa não pelo que ela fez, e sim pelo que não fez (negligência, falta de um maior dever de cuidado e por falhas “ao não alertar sobre riscos associados” ao uso do chatbot de IA). Dado que, entre setembro de 2024 e abril de 2025, “em diversos momentos, o robô não priorizou a integridade física e mental nem tentou prevenir o suicíd3o — muito pelo contrário“.

A solução que vem da China:

Recentemente a China, por meio da Administração do seu Ciber Espaço, abriu consulta pública para apresentar proposta de regulamentação de serviços interativos objetivando combater o que considera “incentivos ao suicídio, manipulação emocional e conteúdo relacionado a jogos de azar, entre outros (…) produtos ou serviços de IA que simulem a personalidade humana e engajem com os usuários por texto, imagens, áudio ou vídeo”.

Intitulada “Medidas Provisórias para a Administração de Serviços Interativos Humanizados Baseados em IA”, trata-se de uma iniciativa pioneira, especialmente pela forma diferenciada como se dá essa abordagem. E sobre a qual o resto do mundo não tem dado a devida atenção e/ou prioridade! Sobretudo porque abre pouco espaço para a discussão mística em torno de uma situação ainda hipotética, como é o caso da Inteligência Artificial Geral. Pois, enquanto os EUA fica vendendo a sua imagem particular de futuro, a China foca no presente e “está literalmente transformando todos os seus setores econômicos com as tecnologias já existentes“.

Diferente porque: primeiro, desmistifica a falsa premissa de que a China não regula a IA pois não escuta ou não atenta para as necessidades de seus cidadãos; segundo, que a única forma de ser um ator competitivo na corrida da IA é por meio da desregulamentação radical ou da negligência para com os danos causados por aquela (este, um contraponto evidente ao posicionamento atual dos EUA); terceiro, por “reconhecer as vulnerabilidades humanas relacionadas à IA e estabelecer medidas técnicas contextuais não só para remediar, mas para prevenir os danos decorrentes do chamado “antropoformismo das IAs”.

Assim, dentre as soluções propostas, a regulação chinesa destaca: a) primeiro a definição, no artigo 2o, tanto do antropoformismo das IAs, quanto o que são “serviços interativos antropomórficos”. Um passo importante pois visa a “aumentar a conscientização e regulamentação da IA de forma mais eficaz. Em comparação à Lei da União Europeia -UE que não define antropomorfismo e tem apenas uma fraca obrigação de transparência a respeito”; b) o artigo 3o anuncia o que considera “desenvolvimento e governança saudável” no campo da IA, no intuito de prevenir abusos e perda de controle. A inovação é, então, incentivada, porém de “forma inclusiva, prudente e supervisionada“.

O artigo 7o se acerca mais minuciosamente das proibições de serviços de IA antropomórficos que ponham em risco a unidade e segurança nacionais, espalhem rumores ou perturbem a ordem econômica e social; insultem ou difamem outrem; prejudiquem os relacionamentos sociais; incentivem, enalteçam ou induzam suicídio, automutilação e outras práticas que afetem a dignidade pessoal e saúde mental dos usuários por meio de violência ou manipulação emocional; e que utilizem métodos como “manipulação algorítmica, informação enganosa e armadilhas emocionais para induzir os usuários a tomar decisões irracionais”.

Já os artigos 8o e 9o prevêem a responsabilização durante todo o ciclo de valor da IA, bem como do que considera “serviço interativo antropomórfico”. Desde o seu desenvolvimento “até ao design, marketing e momento de supervisão” que inclui salvaguardas técnicas seguras e controláveis. Além da revisão dos mecanismos algorítmicos e dos recursos de segurança em tempo real, “como proteção à saúde mental, orientação sobre limites emocionais e alertas sobre riscos de dependência para que não haja a substituição da interação social, o controle da psicologia dos usuários ou a indução de vícios como objetivos de design.”

E aí que reside seu maior Calcanhar de Aquiles, em termos de resistência à sua aplicação em outros países, já que a proposta de lei chinesa sobre IA “deixa claro que os fornecedores de IA são os principais responsáveis pela segurança e proteção dos sistemas de IA antropomórficos, inclusive no que diz respeito à saúde mental e à manipulação emocional“. Especialmente nos artigos 11 e 12, sobre menores e idosos, visto que, por lei, “estão entre os grupos mais vulneráveis afetados pelo antropomorfismo da IA”, bem como “estabelece medidas concretas e específicas para proteger esses grupos”.

- Contudo, não menos importante, resta ao final um questionamento crítico: problemas como esses se resolvem com mais regras e leis, ou com educação (digital literacy)? Visto que “os níveis de conhecimento sobre IA ainda são baixos e as pessoas estão começando a aprender a lidar com os novos riscos” de uma tecnologia emergente.

Sejamos, então, sinceros! Trata-se de uma das propostas de regulação da Inteligência Artificial com maior extensão e rigidez no mundo! Além de sabemos se tratar de um país cujo regime difere dos “sistemas políticos e econômicos dos Estados Unidos e da União Europeia”. Logo, dá-se em um ambiente favorável onde é “mais fácil de controlar e impor regras, padrões e obrigações rigorosas“.

Por outro lado, a proposta chinesa é uma alternativa legítima, principalmente quando almeja se concentrar “na proteção de usuários vulneráveis (especialmente menores, idosos e pessoas com problemas de saúde mental subjacentes), na prevenção de danos da IA em contextos específicos“, assim como na imputação de responsabilização também às empresas fornecedoras de produtos e serviços de IA.

Num dado momento em que regulações mundo a fora mostram-se, além de insuficientes, incapazes de acompanhar o ritmo da inovação tecnológica, estando quase sempre um passo atrás. Vide o caso europeu que passa por um período de inflexão, tendo que reverter muito do seu rigor regulatório para conseguir competir com as gigantes chinesas e estadunidenses. Uma questão geopolítica paradigmática, muito mais do ponto de vista concorrencial do que da salvaguarda de garantias fundamentais, proteção de direitos e liberdades individuais.

Mormente quando se pretende regulamentar sistemas de IA antropomórficas com esse requinte “de detalhe, rigor e preocupação com vulnerabilidades específicas quanto a contexto e riscos potenciais”. Em comparação às leis de IA existentes, incluindo as leis estaduais dos EUA e o AI Act europeu que são “excessivamente abstratas e contextualmente vagas, abrindo caminho para que as empresas de IA façam o mínimo possível, implementem práticas obscuras, evitem a conformidade e abusem do sistema“.

Impressões finais/moral da história:

Com relação ao rápido avanço e popularização de chatbots e agentes de IA, a impressão é que estamos diante de uma via mais fácil, mais rápida, barata e, principalmente, mais cômoda e acessível a uma parcela considerável da população (por isso a tática de colocá-la ao alcance de nossas mãos). Notadamente em um contexto de crise global de saúde mental que intensifica a busca por “Terapeutas de Inteligência Artificial“.

Principalmente no que tange à sua disponibilidade contínua, 24 horas por dia! Isso explica, embora não justifique plenamente a sua grande aceitação pública! Tanto por parte das pessoas quanto de entidades empresariais e governamentais que os estão adotando em massa. Sem garantias de efetividade, contudo, especialmente no campo da experiência pessoal voltada para o mercado consumidor. Por se tratar de um experimento válido, porém que mexe com e interfere em nossa privacidade/intimidade/identidade. Algo que deve ser colocado na balança de prós e contras, a fim de avaliar o que prevalece!

Não é por acaso, então, a vontade de se limitar a liberdade de expressão, bem como a de regular a “profissão” de influencer na internet, como o Congresso Nacional fez recentemente ao aprovar a Lei nº 15.325/2026. Medida que reduzirá sensivelmente o número de influenciadores no mercado digital. Exemplo prático: é aceitável a um jornalista chegar em uma rede social para fazer resenhas e indicar filmes, já que tem lugar de fala, propriedade ou formação profissional, acadêmica para tal. Mas não para opinar sobre relacionamentos amorosos, afetivos, valorá-los e dar dicas comportamentais, uma vez que caberia a um psicólogo, psicoterapeuta ou psiquiatra fazê-lo. Visto que não são os mais indicados para esse tipo de intervenção/interação social.

Do contrário, poderia ser muito perigoso e arriscado; logo, inconsequente e irresponsável fazer alguém seguir cegamente aquele “conselho”, aquela “orientação” e algo desse errado, não saísse como o esperado ou ficasse fora de controle. Isso seguindo-o à risca, sem contraditório, de forma acrítica, sem buscar uma segunda opinião (como é comum na área médica e, portanto, não seria diferente na interação com uma máquina). Ou seja, o perigo está em generalizar, suprimir essas instâncias e/ou extrapolar os limites a que foram designadas sem o alerta de que “a sua palavra” é insuficiente para a tomada de decisão.

Qualquer “jogo”, para ser jogado, precisa de limites, precisa de regras! E isso diz mais sobre o que “não fazer” do que “o fazer propriamente dito”. O caso Adam Raine é uma prova disso!

Para terminar, copio aqui um trecho da edição mais recente da Luiza Jarovsky Newsletter, no Substack, entitulada The Case for AI Regulation, And why you should care | Edition #262 que, já em agosto de 2025, alertava estarmos ainda “no Velho Oeste dos chatbots de IA, onde ainda há pouca ou nenhuma supervisão regulatória de sistemas de IA de uso geral como o ChatGPT, especialmente do ponto de vista da proteção do consumidor“

E, para nosso deleite, cita o tratamento dado pelo Brasil como referência/benchmark global. Medida que, segundo Jarovsky, “todos os países deveriam fazer o mesmo”. Na ocasião, a Procuradoria-Geral da República por meio de notificação extrajudicial deu 72 HORAS para a remoção de TODOS os chatbots de IA que simulam e mantêm conversas de teor sexual com os usuários. Isso porque a plataforma considera “aceitáveis” conversas de teor sexual com crianças. Sem falar que, entre outras razões, o tipo de conteúdo gerado pelos chatbots de IA viola os próprios Padrões da Comunidade.

Pois, ao contrário das redes sociais, a IA pode prejudicar as pessoas individualmente de forma mais sistêmica, escalável e ultra personalizada. E como não queremos repetir os mesmos erros com aquelas, fica a análise da pesquisadora da Universidade de Tel Aviv sobre a que ponto estamos do atual dilema nesse início de 2026:

… diferentemente das redes sociais, existe muito mais alarde e pressão, tanto econômica quanto política, para “eliminar a burocracia”, desregulamentar e permitir que a IA se espalhe livremente, a qualquer custo. E aonde quero chegar com tudo isso? Ainda estamos nos primórdios da ‘era da IA’, quando a IA se torna parte do cotidiano de milhões de pessoas e as influencia de forma abrangente. Qualquer decisão que tomarmos agora, no entanto, se tornará sistêmica e potencialmente irreversível dentro de 20 anos. Se as redes sociais servem de exemplo, este é o momento de definir o tom, os padrões, os valores, as regras e os direitos que devem ser preservados e protegidos a todo custo. Agora é o momento de agir de forma racional, coletiva e democrática para garantir que a IA sirva os seres humanos e a humanidade da melhor maneira possível. Acredito sinceramente que podemos fazer isso, começando no nível local e culminando em alguma forma de consenso global sobre IA.